Qu'est-ce que la sécurité du réseau cloud ?

La sécurité du réseau cloud est un aspect essentiel de la sauvegarde des applications conteneurisées et de leurs données dans le paysage informatique moderne. Il s'agit de sécuriser les communications réseau et les configurations de ces applications, quelle que soit la plateforme d'orchestration utilisée. La sécurité du réseau cloud aborde la segmentation du réseau, les espaces de noms, les réseaux superposés, le filtrage du trafic et le chiffrement pour les conteneurs. En mettant en œuvre des technologies et des bonnes pratiques de sécurité du réseau cloud, les organisations peuvent prévenir efficacement les attaques basées sur le réseau, comme le cryptojacking, les ransomwares et BotNetC2, qui peuvent avoir un impact à la fois sur les réseaux tournés vers le public et sur les réseaux internes utilisés par les conteneurs pour échanger des données.

La sécurité du réseau cloud expliquée

Toutes les workloads s'exécutent sur la même pile réseau et les mêmes protocoles, qu'elles s'exécutent sur des serveurs bare-metal, des machines virtuelles ou dans des conteneurs. En d'autres termes, les charges de travail conteneurisées sont sujettes à bon nombre des mêmes attaques basées sur le réseau que les applications héritées - cryptojacking, ransomware, BotNetC2, et plus encore.

Les menaces de sécurité du réseau, cependant, peuvent avoir un impact sur les conteneurs de deux façons - via les réseaux orientés vers le public qui connectent les applications à internet et via les réseaux internes que les conteneurs Kubernetes utilisent pour échanger des données les uns au sein des autres.

La sécurité du réseau cloud se concentre sur la sécurisation des communications et des configurations réseau pour les applications conteneurisées en général, quelle que soit la plateforme d'orchestration. Il aborde des aspects tels que la segmentation du réseau, les espaces de noms, les réseaux superposés, le filtrage du trafic et le chiffrement pour les conteneurs.

Kubernetes la sécurité du réseau cible la sécurité du réseau au sein d'un cluster Kubernetes et englobe les fonctionnalités spécifiques à Kubernetes, telles que les politiques de réseau, les contrôles d'entrée et de sortie, l'isolation de l'espace de noms, le contrôle d'accès basé sur les rôles (RBAC) et la mise en œuvre du maillage de services.

La détection des signes d'activité malveillante sur les deux types de réseaux exige à la fois la sécurité des conteneurs et la sécurité du réseau Kubernetes. Comme il s'agit de domaines distincts, ils justifient des discussions séparées pour couvrir leurs aspects uniques. Dans cette section, nous allons approfondir les différents aspects de la sécurité du réseau cloud en ce qui concerne les conteneurs et discuter des meilleures pratiques pour protéger votre environnement.

Sécurité du réseau cloud

Une fois déployés, les conteneurs doivent être protégés contre les tentatives de vol de données propriétaires et de ressources de calcul. La sécurité du réseau cloud restreint de manière proactive les communications indésirables et empêche les menaces d'attaquer vos applications une fois qu'elles sont déployées.

Les pare-feu de nouvelle génération conteneurisés, la sécurité des applications web et des API (WAAS), et les outils de microsegmentation inspectent et protègent l'ensemble du trafic entrant et sortant des conteneurs (nord-sud et est-ouest), en accordant une visibilité de couche 7complète, et un contrôle sur l'environnement Kubernetes. En outre, les pare-feu conteneurisés évoluent dynamiquement en fonction de l'évolution rapide de la taille et des demandes de l'infrastructure des conteneurs afin d'assurer la sécurité et la bande passante pour les opérations commerciales.

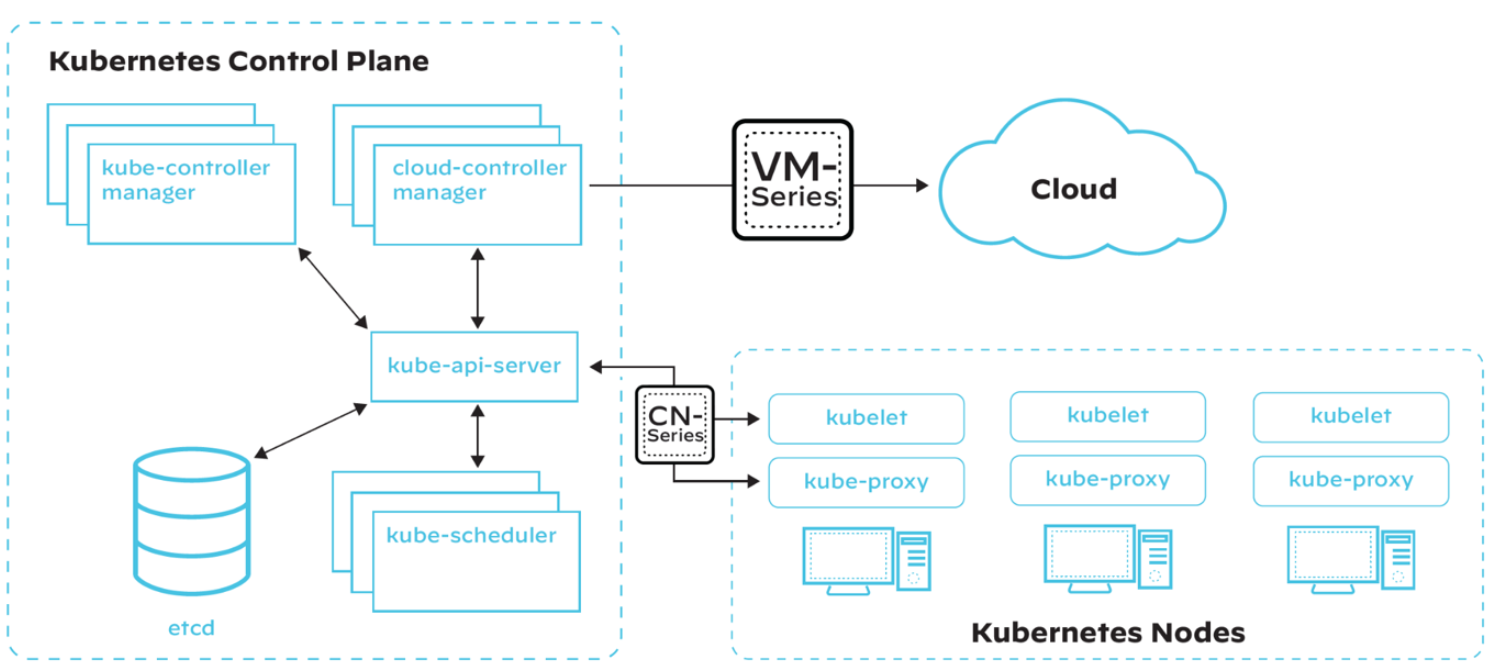

Figure 1 : Une architecture Kubernetes simplifiée avec superposition de VM-Series (pare-feu nouvelle génération virtualisé) et CN-Series (pare-feu conteneurisé adapté à la sécurisation des applications conteneurisées basées sur Kubernetes).

Segmentation du réseau

La segmentation du réseau consiste à diviser un réseau en segments plus petits et isolés afin de limiter les accès non autorisés, de contenir les menaces potentielles et d'améliorer les performances globales du réseau. Dans les environnements conteneurisés, les équipes de sécurité peuvent réaliser une segmentation du réseau par le biais de diverses méthodes.

Espaces de nommage du réseau

Les espaces de noms réseau permettent d'isoler les conteneurs en créant une pile réseau distincte pour chacun d'entre eux, y compris leurs propres interfaces réseau, tables de routage et règles de pare-feu. En tirant parti des espaces de noms réseau, vous pouvez empêcher les conteneurs d'interférer avec les configurations réseau des autres et limiter leur visibilité aux seules ressources réseau requises.

Réseaux superposés

Les réseaux superposés créent une couche de réseau virtuel au-dessus du réseau physique existant, ce qui permet aux conteneurs de communiquer entre différents hôtes comme s'ils se trouvaient sur le même réseau. Parmi les solutions de réseaux superposés populaires pour les conteneurs, citons le pilote superposé intégré de Docker, Flannel et Weave.

Partitions de réseau et groupes de sécurité

Les partitions réseau et les groupes de sécurité peuvent segmenter davantage les réseaux de conteneurs en créant des frontières logiques et en appliquant des règles de pare-feu spécifiques pour restreindre le trafic entre les segments.

Filtrage du trafic et règles de pare-feu

Les Pare-feu nouvelle génération conteneurisés empêchent les logiciels malveillants de pénétrer et de se propager au sein du cluster, tout en prévenant les connexions sortantes malveillantes utilisées pour l'exfiltration de données et les attaques de commandement et de contrôle (C2). Bien que les outils de sécurité shift-left offrent une protection au moment du déploiement contre les vulnérabilités connues, les pare-feu nouvelle génération conteneurisés offrent une protection contre les vulnérabilités inconnues et non corrigées.

Le filtrage du trafic et les règles de pare-feu sont essentiels pour contrôler le flux de trafic entre les conteneurs, ainsi qu'entre les conteneurs et l'hôte.

Filtrage des entrées et des sorties

Le filtrage des sorties contrôle le trafic sortant d'un conteneur, tandis que le filtrage des entrées contrôle le trafic entrant dans un conteneur. En appliquant un filtrage à l'entrée et à la sortie, vous pouvez limiter l'exposition de vos conteneurs aux menaces externes et restreindre leur communication aux seuls services nécessaires.

Application de règles de pare-feu au trafic des conteneurs

Les règles de pare-feu peuvent être appliquées à différents niveaux, notamment au niveau de l'hôte, du conteneur et du réseau. Vous pouvez utiliser Linux iptables ou firewalld, par exemple, pour créer des règles qui régissent le trafic des conteneurs et protègent votre infrastructure contre les accès non autorisés et les activités malveillantes.

Équilibrage des charges et routage du trafic

L'équilibrage de la charge et le routage du trafic sont importants pour répartir le trafic entre plusieurs conteneurs et garantir la haute disponibilité de vos applications. Des solutions comme HAProxy, NGINX ou les services intégrés de Kubernetes peuvent être utilisées pour acheminer le trafic vers le conteneur approprié en fonction de règles et de contrôles de santé prédéfinis.

Cryptage et communication sécurisée

Le chiffrement et la sécurisation des communications entre les conteneurs, et entre les conteneurs et l'hôte, sont essentiels pour protéger les données sensibles et maintenir l'intégrité de vos applications.

Transport Layer Security (TLS) pour le trafic des conteneurs

TLS assure le chiffrement et l'authentification des données transmises sur un réseau. En mettant en œuvre TLS pour le trafic des conteneurs, vous pouvez vous assurer que les données transmises entre les conteneurs et entre les conteneurs et l'hôte sont chiffrées et sécurisées contre l'écoute ou la falsification. Pour ce faire, vous pouvez utiliser des outils comme OpenSSL ou Let's Encrypt pour générer et gérer des certificats TLS pour vos conteneurs.

Sécuriser les communications de conteneur à conteneur

Pour sécuriser les communications entre les conteneurs, vous pouvez utiliser des solutions natives des conteneurs, comme les réseaux cryptés intégrés de Docker, ou des outils tiers comme Cilium, qui fournit une sécurité réseau adaptée aux API pour les conteneurs. Ces solutions vous permettent de mettre en œuvre le chiffrement, l'authentification et l'autorisation pour le trafic de conteneur à conteneur.

Sécuriser les communications entre conteneurs et hôtes

Il est possible de garantir la sécurité des communications entre les conteneurs et l'hôte en utilisant des mécanismes de chiffrement et d'authentification au niveau de l'hôte, tels que SSH ou des API protégées par TLS, pour contrôler l'accès aux interfaces de gestion des conteneurs et aux systèmes de stockage des données.

Sécurité du réseau de Kubernetes

Politiques de réseau

Les stratégies réseau sont une fonctionnalité clé de Kubernetes qui vous permet de contrôler le flux de trafic au sein de votre cluster et entre votre cluster et les réseaux externes. Les outils modernes permettent aux équipes de sécurité de définir des politiques qui déterminent essentiellement qui et quoi sont autorisés à accéder à un microservice donné. Les organisations ont besoin d'un cadre pour définir ces politiques et s'assurer qu'elles sont maintenues de manière cohérente dans un environnement d'applications conteneurisées hautement distribué.

Définir et appliquer des politiques de réseau

Les politiques de réseau Kubernetes sont définies à l'aide de fichiers YAML, qui spécifient le trafic autorisé entre les composants tels que les pods, les services et les espaces de noms. Une fois définies, ces politiques peuvent être appliquées à l'aide de plugins réseau qui prennent en charge l'API de politique réseau de Kubernetes, comme Calico ou Cilium.

Liste blanche et liste noire du trafic

Les stratégies réseau peuvent être utilisées pour mettre sur liste blanche ou noire le trafic entre les composants de votre cluster en fonction de critères tels que les étiquettes de pods, les adresses IP ou les espaces de noms. L'établissement de ces règles vous permettra de contrôler quels services peuvent communiquer entre eux et d'empêcher l'accès non autorisé à des données ou des ressources sensibles.

Isolation et segmentation de l'espace de nommage

En appliquant des stratégies de réseau au niveau de l'espace de noms, vous pouvez isoler et segmenter les applications ou les environnements au sein de votre cluster, en limitant le trafic aux seuls composants nécessaires et en prévenant les risques potentiels pour la sécurité.

Contrôles des entrées et des sorties

Le contrôle du trafic d'entrée et de sortie est essentiel pour gérer le flux de données entrant et sortant de votre cluster Kubernetes et le protéger contre les menaces externes.

Contrôleurs d'entrée et équilibrage de la charge

Les contrôleurs d'entrée dans Kubernetes gèrent l'acheminement du trafic externe vers les services appropriés au sein de votre cluster en fonction de règles prédéfinies. L'équilibrage de charge peut être réalisé par des services Kubernetes intégrés ou des solutions tierces comme NGINX et HAProxy. Ces solutions vous permettent d'acheminer le trafic en fonction de critères tels que le chemin, l'hôte ou les en-têtes. Ils vous permettent également de fournir une terminaison TLS et d'autres fonctions de sécurité.

Meilleures pratiques en matière d'accès entrant

- Corrigez la politique Kubernetes par défaut "any-any-any allow" en appliquant une politique deny-all pour chaque espace de noms.

- Empêchez les services d'accepter du trafic entrant directement à partir d'IP externes, à moins qu'un équilibreur de charge ou une entrée ne soit connecté. N'autorisez le trafic entrant qu'à partir des répartiteurs de charge ou des entrées.

- Limitez le trafic à des protocoles et ports spécifiques en fonction des exigences du service (par exemple, HTTP/HTTPS pour les services web, UDP 53 pour le service DNS).

- Ils n'acceptent que le trafic provenant d'autres services (pods) qui les consomment, que ce soit dans le même espace de noms ou dans un autre.

- Pour créer une politique d'entrée à partir d'un module dans un autre espace de noms, ajoutez une étiquette à l'espace de noms.

Gestion du trafic de sortie

Le contrôle du trafic sortant de votre cluster Kubernetes est essentiel pour éviter les fuites de données et garantir que les connexions sortantes sont limitées aux seules destinations requises. Vous pouvez y parvenir en utilisant des stratégies de réseau de sortie, qui vous permettent de définir des règles pour le trafic sortant de vos pods ou espaces de noms. En outre, des passerelles de sortie ou des solutions de proxy comme Squid peuvent être utilisées pour contrôler et surveiller le trafic sortant de votre cluster.

Meilleures pratiques en matière d'accès aux sorties

- Comprendre la nécessité de chaque service externe utilisé par vos microservices. Des produits comme Prisma Cloud Compute Defender peuvent aider à identifier les flux externes engagés par les microservices.

- Si un pod doit se connecter à un nom DNS (FQDN) sans adresse IP fixe, utilisez un pare-feu externe ou un proxy, car les stratégies réseau de Kubernetes ne prennent en charge que les adresses IP.

- Empêchez le trafic sortant des pods qui n'ont pas besoin de connexions externes afin de réduire les risques d'exfiltration de données ou de téléchargement de binaires malveillants.

- Appliquez une politique de blocage des sorties si vous n'avez pas de dépendances externes, mais assurez-vous que les services essentiels comme le service DNS Kubernetes restent connectés lors de l'application des politiques de sortie.

La microsegmentation basée sur l'identité permet de restreindre la communication entre les applications aux couches 3 et 4, tandis que les pare-feu nouvelle génération conteneurisés effectuent une Inspection approfondie des paquets de la couche 7 et analysent tout le trafic autorisé afin d'identifier et de prévenir les menaces connues et inconnues.

Politiques et sécurité DNS

Le DNS fait partie intégrante du réseau Kubernetes, car il assure la résolution des noms pour les services et autres composants au sein de votre cluster. Assurez la sécurité et l'intégrité de votre infrastructure DNS pour prévenir les attaques telles que DNS spoofing ou cache poisoning.

Kubernetes fournit des politiques DNS intégrées pour contrôler le comportement de la résolution DNS au sein de votre cluster, et vous pouvez également utiliser des fournisseurs DNS externes ou des solutions de sécurité DNS comme DNSSec pour renforcer la sécurité de votre infrastructure DNS.

Service Mesh et chiffrement des réseaux

Service mesh est une couche d'infrastructure dédiée qui fournit des fonctions de réseau avancées, telles que le routage du trafic, l'équilibrage des charges et la sécurité pour vos microservices et applications conteneurisées.

Mise en œuvre du maillage de services

Les solutions de maillage de services comme Istio et Linkerd peuvent être intégrées à votre cluster Kubernetes pour fournir des capacités de mise en réseau avancées et renforcer la sécurité de vos applications conteneurisées. Ces solutions offrent des fonctionnalités telles que TLS mutuel, le contrôle d'accès et le chiffrement du trafic, qui peuvent contribuer à protéger vos applications, en particulier les microservices, contre diverses menaces de sécurité.

TLS mutuel (mTLS) pour des communications sécurisées

TLS mutuel (mTLS) est un protocole de sécurité dans lequel le client et le serveur authentifient leurs identités respectives avant d'établir une connexion sécurisée. Contrairement au protocole TLS traditionnel, où seul le serveur est authentifié par le client, le protocole mTLS ajoute une couche de sécurité supplémentaire en exigeant du client qu'il présente un certificat. Cette exigence supplémentaire permet de vérifier que les deux parties sont bien celles qu'elles prétendent être, ce qui peut contribuer à prévenir les accès non autorisés, les fuites de données et les attaques de type "man-in-the-middle".

Observabilité et contrôle du trafic sur le réseau

Les solutions de maillage de services offrent également une observabilité et un contrôle du trafic de votre réseau, ce qui vous permet de surveiller les performances et la sécurité de vos applications en temps quasi réel. L'identification précoce d'un accès non autorisé, de modèles de trafic inhabituels et d'autres problèmes de sécurité potentiels signifie que vous pouvez prendre des mesures correctives précoces pour atténuer les risques.

Cryptage du trafic et des données sensibles

Pour garantir la confidentialité et l'intégrité des données au sein de votre cluster, il est essentiel de mettre en œuvre des techniques de chiffrement pour les communications internes et externes.

IPsec pour le chiffrement des communications entre hôtes

IPsec protège le trafic de la grappe en chiffrant les communications entre tous les hôtes du maître et des nœuds. Gardez à l'esprit la surcharge IPsec et reportez-vous à votre documentation sur l'orchestration de conteneurs pour activer les communications IPsec au sein du cluster. Importez les certificats nécessaires dans la base de données de certificats appropriée et créez une stratégie pour sécuriser la communication entre les hôtes de votre cluster.

Configuration de l'unité de transmission maximale (MTU) pour l'overhead IPsec

Ajustez le MTU de la route ou de la commutation pour tenir compte de la surcharge de l'en-tête IPsec. Par exemple, si le cluster fonctionne sur un réseau Ethernet avec une unité de transmission maximale (MTU) de 1500 octets, modifiez la valeur MTU SDN pour tenir compte de la surcharge d'encapsulation IPsec et SDN.

Activation de TLS pour la communication API dans le cluster

Kubernetes suppose que les communications API au sein du cluster sont chiffrées par défaut à l'aide de TLS. La plupart des méthodes d'installation créent et distribuent les certificats requis aux composants de la grappe. Sachez toutefois que certains composants et certaines méthodes d'installation peuvent activer des ports locaux par l'intermédiaire de HTTP. Les administrateurs doivent se tenir informés des paramètres de chaque composant afin d'identifier et de traiter le trafic potentiellement non sécurisé.

Sécurité du plan de contrôle de Kubernetes

Les plans de contrôle, en particulier dans les clusters Kubernetes, sont des cibles de choix pour les attaques. Pour améliorer la sécurité, renforcez les composants suivants en les inspectant et en les configurant correctement :

- Les nœuds et leurs périmètres

- Nœuds maîtres

- Composantes essentielles

- API

- Nacelles orientées vers le public

Si la configuration par défaut de Kubernetes offre un certain niveau de sécurité, l'adoption de bonnes pratiques peut renforcer le cluster pour les charges de travail et les communications d'exécution.

Politiques de réseau (règles de pare-feu)

Le réseau plat de Kubernetes permet à tous les déploiements d'atteindre d'autres déploiements par défaut, même à travers les espaces de noms. Ce manque d'isolation entre les pods signifie qu'une charge de travail compromise pourrait lancer une attaque sur d'autres composants du réseau. La mise en œuvre de politiques de réseau permet d'assurer l'isolement et la sécurité.

Politique de sécurité des pods

Kubernetes permet aux pods de fonctionner avec diverses configurations non sécurisées par défaut. Par exemple, l'exécution de conteneurs privilégiés avec des droits root sur l'hôte présente un risque élevé, tout comme l'utilisation des espaces de noms et du système de fichiers de l'hôte ou le partage du réseau de l'hôte. Les politiques de sécurité des pods permettent aux administrateurs de limiter les privilèges et les autorisations d'un pod avant d'en autoriser le déploiement dans le cluster. Isoler les pods non dépendants pour qu'ils ne se parlent pas les uns aux autres à l'aide de politiques de réseau permettra d'éviter les mouvements latéraux entre les conteneurs en cas de violation.

Secrets Chiffrement

Les distributions de base de Kubernetes ne chiffrent pas les secrets au repos par défaut (bien que les services gérés comme GKE le fassent). Si un pirate accède au magasin de valeurs clés (typiquement Etcd), il peut accéder à tout ce qui se trouve dans le cluster, y compris les secrets non chiffrés. Le chiffrement de la mémoire d'état de la grappe protège celle-ci contre l'exfiltration des données au repos.

Contrôle d'accès basé sur les rôles

Bien que le RBAC ne soit pas exclusif à Kubernetes, il doit être configuré correctement pour éviter la compromission des clusters. RBAC permet un contrôle granulaire des composants du cluster auxquels un pod ou un utilisateur peut accéder. En limitant ce que les utilisateurs et les pods peuvent voir, mettre à jour, supprimer et créer au sein du cluster, le RBAC permet de limiter les dommages potentiels d'une compromission.

Assurer la sécurité du plan de contrôle grâce à des correctifs virtuels

Réduire au minimum l'accès des administrateurs aux plans de contrôle et s'assurer que votre serveur API n'est pas exposé publiquement sont les principes de base les plus importants en matière de sécurité.

Les équipes DevOps et SecOps peuvent identifier les vulnérabilités dans les progiciels d'application, mais l'atténuation de ces risques prend du temps. Les progiciels vulnérables doivent être remplacés ou corrigés et testés avant d'être déployés, ce qui laisse l'environnement exposé jusqu'à ce que le problème soit résolu. Des solutions comme Prisma Cloud automatisent la cartographie des vulnérabilités pour chaque charge de travail afin de fournir des correctifs virtuels pour les vulnérabilités connues. En utilisant son composant WAAS , la solution ajuste les politiques d'inspection du trafic pour détecter et bloquer les exploits à distance basés sur HTTP.

Meilleures pratiques de sécurité du réseau pour les conteneurs et Kubernetes.

En résumé des domaines abordés, les meilleures pratiques suivantes servent de liste de contrôle pour garantir que vos équipes sont équipées pour protéger vos applications et données conteneurisées contre les menaces basées sur le réseau.

Surveillance et enregistrement du trafic sur le réseau

Il est primordial de garder un œil sur votre trafic réseau pour détecter et répondre aux incidents de sécurité et maintenir la santé globale de votre environnement conteneurisé.

Solutions centralisées de journalisation et de surveillance

La mise en œuvre d'une solution centralisée de journalisation et de surveillance pour votre environnement de conteneurs et Kubernetes, telle que ELK Stack, Prometheus ou Prisma Cloud, peut vous aider à collecter, analyser et visualiser les données de trafic réseau provenant de différents domaines. Un accès facile à des données centralisées vous permettra d'identifier des tendances, de détecter des anomalies et d'obtenir des informations sur les performances et la sécurité de votre infrastructure.

Détecter les incidents de sécurité et y répondre

La surveillance du trafic réseau et l'établissement d'alertes en cas d'activités inhabituelles ou suspectes permettent de détecter et de réagir rapidement aux incidents impliquant un accès non autorisé, l'exfiltration de données et d'autres activités malveillantes. Les équipes de sécurité sont équipées pour prendre les mesures appropriées, telles que l'isolement des composants affectés, le blocage des IP malveillantes ou la mise à jour des règles de pare-feu en temps opportun.

Visualisation et analyse du trafic sur le réseau

La visualisation et l'analyse des données relatives au trafic de votre réseau peuvent vous aider à identifier des schémas et des tendances susceptibles d'indiquer des risques potentiels pour la sécurité. Des outils tels que Kibana, Grafana ou des tableaux de bord personnalisés peuvent être utilisés pour créer des représentations visuelles de votre trafic réseau, ce qui vous permet de repérer les anomalies et d'enquêter plus efficacement sur les incidents de sécurité.

Configurations de réseaux sécurisés

Le durcissement des configurations de votre réseau et la mise en œuvre de contrôles d'accès solides sont essentiels pour protéger votre environnement de conteneurs et Kubernetes contre les menaces de sécurité.

Renforcer les paramètres des réseaux de l'hôte et du cloud

Le maintien de la sécurité de votre environnement exige de garantir des configurations de réseau sécurisées à la fois pour votre hôte de conteneur et pour les conteneurs individuels. Les mesures essentielles consistent à désactiver les services réseau inutilisés, à limiter l'accès au réseau aux seuls composants nécessaires et à appliquer les correctifs et les mises à jour de sécurité à votre système d'exploitation hôte et à l'exécution des conteneurs.

Contrôles d'accès au réseau et authentification

Pour empêcher les accès non autorisés et maintenir l'intégrité de votre environnement de conteneurs et de Kubernetes, il est essentiel de mettre en œuvre des contrôles d'accès et des mécanismes d'authentification solides. Les principales mesures consistent à utiliser le contrôle d'accès basé sur les rôles (RBAC) pour gérer les autorisations des utilisateurs dans Kubernetes, à intégrer l'authentification multifactorielle (MFA) et à employer des solutions de sécurité réseau, telles que des VPN ou des pare-feu, pour limiter l'accès à votre environnement.

Évaluations régulières de la sécurité du réseau

Des évaluations régulières de la sécurité du réseau - analyses de vulnérabilité, tests de pénétration et audits de sécurité - sont indispensables lorsqu'il s'agit d'identifier les faiblesses potentielles de votre environnement de conteneurs et de Kubernetes. Les principaux aspects de ces évaluations consistent à examiner les configurations de réseau, les règles de pare-feu et les politiques de sécurité pour s'assurer qu'elles respectent les meilleures pratiques du secteur et les exigences en matière de conformité.

En suivant ces bonnes pratiques et en mettant en œuvre des mesures de sécurité réseau efficaces, vous pouvez fortifier votre environnement de conteneurs et Kubernetes contre les menaces potentielles liées au réseau et garantir la sécurité et l'intégrité de vos applications et de vos données.

FAQ sur la sécurité du réseau cloud

Le MTU, ou unité de transmission maximale, désigne la plus grande taille d'un paquet de données pouvant être transmis sur un réseau. C'est un paramètre qui contribue à déterminer l'efficacité et la performance de la communication de données à travers les réseaux. Le protocole de contrôle de transmission (TCP) utilise le MTU pour déterminer la taille maximale de chaque paquet dans les transmissions internet.

Pour tenir compte de l'en-tête supplémentaire introduit par le cryptage et l'encapsulation, il est nécessaire d'ajuster la valeur du MTU lorsque vous utilisez IPsec pour des communications sécurisées. Par exemple, si le cluster Kubernetes fonctionne sur un réseau Ethernet avec un MTU par défaut de 1500 octets, la valeur du MTU doit être réduite pour tenir compte de la surcharge d'encapsulation IPsec et SDN. L'ajustement empêche la fragmentation des paquets et garantit une transmission de données plus efficace et plus sûre.