Qu’est-ce que la microsegmentation ?

La microsegmentation permet d’assurer la gestion des accès réseau entre les workloads. Grâce à elle, les administrateurs peuvent gérer des politiques de sécurité qui limitent le trafic conformément au principe du moindre privilège et au Zero Trust. Au sein de l’entreprise, la microsegmentation est employée dans une triple optique : réduire la surface d’attaque, optimiser la neutralisation des compromissions et renforcer la conformité règlementaire.

La microsegmentation en bref

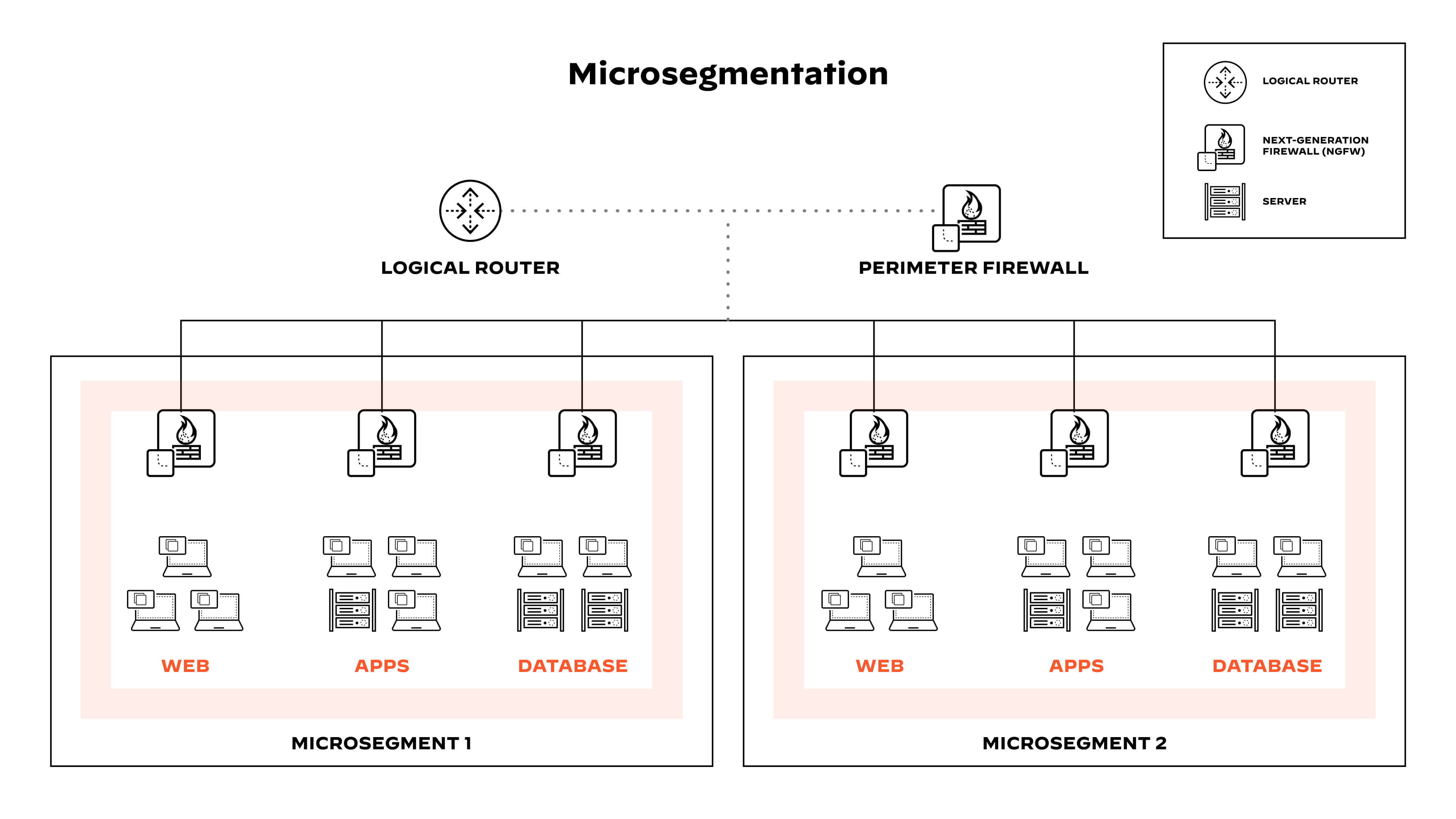

Microsegmenter, c’est diviser un réseau en différents segments soumis chacun à des contrôles de sécurité en phase avec ses exigences propres.

En pratique, un logiciel de microsegmentation doté de technologies de virtualisation réseau crée des zones sécurisées à granularité fine dans les environnements cloud. Les workloads sont ainsi isolés, chacun d’entre eux étant protégé à l’aide de politiques personnalisées. Dans le même esprit, chaque machine virtuelle (VM) du réseau peut être sécurisée jusqu’au niveau applicatif, à l’aide de contrôles de sécurité ciblés.

Une telle granularité se révèle précieuse dans les environnements cloud actuels qui exécutent plusieurs applications sur un même serveur ou une même machine virtuelle. Plus précisément, au lieu d’appliquer une seule politique de sécurité pour tout le serveur, l’entreprise peut opter pour des contrôles de sécurité spécifiques à un workload ou une application donnée.

Figure 1 : La microsegmentation consiste à diviser un réseau en segments pour limiter le trafic conformément au principe du Zero Trust.

Qu’est-ce qu’un workload ?

Au sens large, un workload, ou « charge de travail » en français, désigne les ressources et processus nécessaires à l’exécution d’une application. Les hôtes, machines virtuelles et containers sont donc des workloads.

À l’heure où les applications sont de plus en plus distribuées sur différentes architectures cloud-native en fonction des besoins métiers, une entreprise peut exécuter des workloads transverses à différents data centers et environnements hybrides et multicloud.

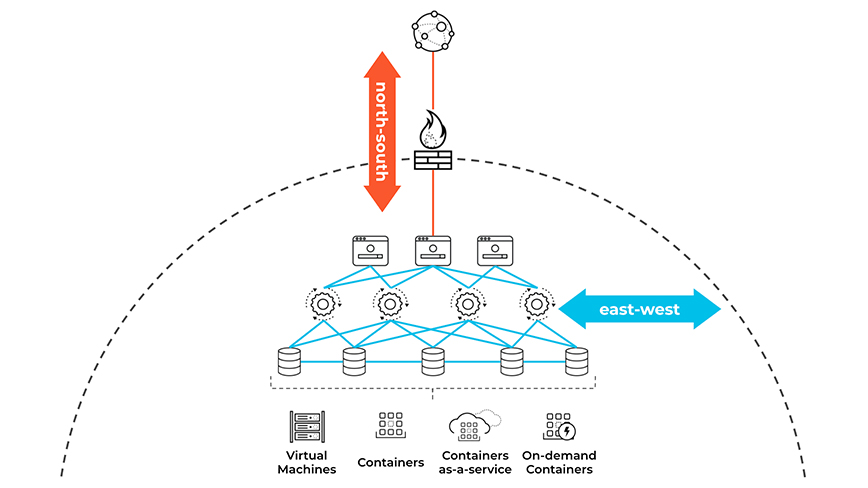

Au-delà de la protection du périmètre réseau

Dans la plupart des organisations, la protection du réseau repose sur une sécurité périmétrique. Selon ce modèle, des pare-feu et autres dispositifs de sécurité réseau inspectent le trafic nord-sud (client-serveur) qui traverse le périmètre de sécurité, puis bloquent les activités suspectes. À l’inverse, le trafic est-ouest (entre workloads) est lui acheminé sans inspection, car les assets situés à l’intérieur du périmètre sont implicitement considérés comme sûrs.

Figure 2 : Trafic nord-sud (client-serveur) vs est-ouest (entre workloads)

Dans les data centers comme dans le cloud, les communications est-ouest dominent le plus souvent les schémas de trafic. Problème : les protections périmétriques n’ont aucune visibilité sur ce type de trafic. Une aubaine pour les cybercriminels qui ont ainsi le loisir de se déplacer latéralement entre les workloads.

Concrètement, le réseau ouvre des voies de communication fiables entre les workloads et détermine si, oui ou non, deux terminaux sont autorisés à interagir l’un avec l’autre. Or, ce type de décision ne peut être appliquée sans une microsegmentation adaptée. Et pour ne rien laisser au hasard, segmenter le réseau conformément au principe du moindre privilège permet de limiter les déplacements latéraux et de circonscrire les compromissions.

Figure 3 : La microsegmentation permet de contenir et d’isoler une attaque.

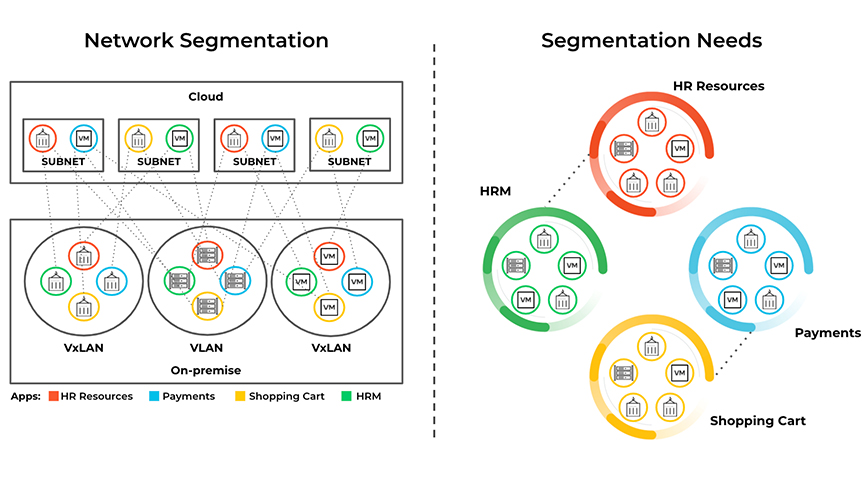

Problématiques de segmentation du réseau

Segmenter un réseau revient à le diviser en plusieurs segments. Une stratégie bénéfique tant sur le plan des performances que de la sécurité :

- Performance – Diviser le réseau en sous-réseaux et VLAN réduit la portée des paquets de diffusion et améliore les performances réseau.

- Sécurité – Les équipes de sécurité réseau peuvent appliquer des listes de contrôle d’accès (ACL) aux VLAN et aux sous-réseaux pour faire d’une pierre deux coups : isoler les machines sur différents segments du réseau et empêcher la menace de se propager en cas de compromission.

Pour autant, segmenter le réseau dans une optique de sécurité apporte son lot de difficultés. De fait, les besoins de segmentation ne sont pas toujours en phase avec l’architecture réseau. Lorsque c’est le cas, la restructuration du réseau ou la reconfiguration des VLAN et sous-réseaux se révèle aussi complexe que chronophage.

Figure 4 : La segmentation du réseau à l’aide de VLAN et de sous-réseaux est une méthode éprouvée pour garantir des performances réseau optimales en séparant les domaines de diffusion.

Mode de fonctionnement de la microsegmentation

Aussi appelée segmentation Zero Trust ou segmentation basée sur les identités, la microsegmentation permet de satisfaire aux exigences de segmentation sans avoir à repenser l’architecture réseau. Pour les équipes de sécurité, c’est la promesse de pouvoir isoler les workloads du réseau en vue de limiter la capacité de latéralisation des attaques. En pratique, on peut classer les contrôles de microsegmentation en trois catégories :

- Les solutions basées sur des agents utilisent un agent logiciel sur le workload et isolent de façon granulaire les hôtes et containers individuels. Plus spécifiquement, elles peuvent s’appuyer sur le pare-feu intégré à l’hôte ou isoler un workload en fonction de son identité ou de ses attributs.

- Les contrôles de segmentation basés sur le réseau reposent sur l’infrastructure réseau. Cette approche tire parti des équipements physiques et virtuels (équilibreurs de charge, commutateurs, réseaux SDN et overlays) pour appliquer la politique.

- Les contrôles cloud natifs exploitent les fonctionnalités du fournisseur de services cloud (par exemple, groupe de sécurité Amazon, pare-feu Azure ou pare-feu Google Cloud).

La microsegmentation assure une sécurité homogène dans les clouds privés et publics en adhérant à trois principes fondamentaux : visibilité, sécurité granulaire et adaptation dynamique.

Dans les faits, une solution de microsegmentation doit fournir une visibilité sur l’ensemble du trafic réseau, et ce à l’échelle des data centers et des clouds. Face à cet impératif, l’option la plus efficace pour surveiller le trafic consiste à l’analyser dans le contexte du workload (par exemple, cloud, application, orchestrateurs), par opposition aux journaux contenant uniquement des adresses IP et des ports.

Du côté des administrateurs réseau, la sécurité granulaire permet de renforcer les défenses en définissant des politiques spécifiques pour les applications critiques. L’objectif : empêcher toute latéralisation des menaces par l’application de règles qui contrôlent précisément le trafic entrant et sortant au niveau de workloads donnés, par exemple pour le cycle de paie mensuel ou les mises à jour des bases de données RH.

Un autre avantage de la microsegmentation est sa capacité à protéger les environnements dynamiques. Par exemple, avec les architectures cloud-native comme les containers et Kubernetes, les démarrages et arrêts sont incessants. Et puisque les adresses IP attribuées aux workloads cloud sont éphémères, elles ne peuvent pas servir de base à la gestion des règles. C’est là que la microsegmentation prend tout son sens. En effet, les politiques de sécurité sont exprimées en termes d’identités ou d’attributs (env=prod, app=hrm, etc.) plutôt qu’en langage réseau (par exemple, 10.100.0.10 tcp/80). Les modifications apportées à l’application ou à l’infrastructure déclenchent ainsi des révisions automatiques des politiques de sécurité en temps réel – le tout, sans intervention humaine.

Types de microsegmentation

Un autre avantage de la microsegmentation est sa capacité à protéger les environnements dynamiques. Par exemple, avec les architectures cloud-native comme les containers et Kubernetes, les démarrages et arrêts sont incessants. Et puisque les adresses IP attribuées aux workloads cloud sont éphémères, elles ne peuvent pas servir de base à la gestion des règles. C’est là que la microsegmentation prend tout son sens. En effet, les politiques de sécurité sont exprimées en termes d’identités ou d’attributs (env=prod, app=hrm, etc.) plutôt qu’en langage réseau (par exemple, 10.100.0.10 tcp/80). Les modifications apportées à l’application ou à l’infrastructure déclenchent ainsi des révisions automatiques des politiques de sécurité en temps réel – le tout, sans intervention humaine.

Segmentation des containers

La containerisation est une technologie très répandue qui permet à plusieurs applications ou services de s’exécuter dans des containers distincts sur un seul système hôte. Ainsi, un container peut facilement accéder aux données et fichiers de configuration d’un autre container, d’où des problèmes potentiels en termes de sécurité. C’est là que la segmentation des containers entre en jeu : en isolant les containers les uns des autres et du système hôte, elle renforce la sécurité et réduit la surface d’attaque.

Bonnes pratiques de segmentation des containers

- Isolation des containers : afin d’empêcher tout accès non autorisé, chaque container doit être isolé des autres containers exécutés sur le même système hôte, par exemple à l’aide de technologies comme Docker et Kubernetes, qui disposent de mécanismes d’isolation intégrés.

- Segmentation réseau : pour séparer les containers les uns des autres, on peut utiliser des techniques de segmentation du réseau. Concrètement, cela implique de créer des réseaux distincts pour chaque container et de configurer des règles de pare-feu afin d’autoriser ou de bloquer le trafic entre les containers.

- Contrôle d’accès basé sur les rôles : dans le cadre de cette approche, on s’appuie sur les rôles et autorisations des utilisateurs pour définir des politiques d’accès pour différents containers. Cela permet de garantir que seuls les utilisateurs et processus autorisés peuvent accéder aux containers.

- Signature d’images : on peut signer numériquement les images de container pour éviter qu’elles ne soient altérées et pour ne déployer que des images de confiance en production. De quoi limiter les risques de sécurité.

- Protection au runtime : les outils de protection de l’environnement d’exécution (runtime) surveillent l’activité des containers et détectent tout comportement inhabituel, symptomatique d’une compromission potentielle. L’idéal pour repérer et prévenir les attaques en temps réel, avec à la clé des environnements containerisés mieux protégés.

La segmentation des containers contribue à assurer la sécurité des applications et des services containerisés. Plus précisément, en isolant les containers et en appliquant des politiques de contrôle d’accès, l’entreprise peut réduire la surface d’attaque et empêcher tout accès non autorisé aux données et ressources sensibles. Mais attention : la segmentation des containers doit être implémentée dans le cadre d’une politique de sécurité globale alliant sécurité réseau, contrôle d’accès et protection au runtime.

Segmentation des utilisateurs dans le cloud

La segmentation des utilisateurs vise à garantir que ces derniers ont accès uniquement aux ressources dont ils ont besoin dans le cadre de leurs fonctions. Dans le contexte de la sécurité du cloud, cela passe par la définition des droits d’accès utilisateurs sur la base de leurs différents rôles et responsabilités au sein de l’organisation. Grâce à cette segmentation, les données et ressources sensibles ne sont exposées qu’aux seuls utilisateurs autorisés, ce qui réduit mécaniquement la surface d’attaque.

Face à des environnements cloud dynamiques et en perpétuelle mutation, la segmentation des utilisateurs s’impose comme un pilier essentiel d’une stratégie de sécurité cloud complète. Dans cette optique, voici les principaux points à prendre en compte :

- Contrôle d’accès basé sur les rôles : cette approche implique de créer et de définir des autorisations pour tous les rôles, avant d’affecter chaque utilisateur au rôle qui correspond à sa fiche de poste. Résultat, les utilisateurs n’ont accès qu’aux ressources dont ils ont besoin dans le cadre de leurs missions, ce qui réduit le risque de compromission intentionnelle ou accidentelle.

- Authentification multifacteur (MFA) : cette technique oblige les utilisateurs à s’authentifier à l’aide d’au moins deux identifiants (mot de passe, jeton de sécurité ou données biométriques) pour accéder à une ressource. La MFA a prouvé sa capacité à empêcher l’accès non autorisé aux ressources cloud, en particulier lorsqu’elle est combinée au contrôle d’accès basé sur les rôles.

- Surveillance continue : la détection et le traitement des incidents de sécurité en temps réel passent obligatoirement par une surveillance continue de l’activité des utilisateurs. Les données des journaux et le comportement des utilisateurs doivent ainsi être passés à la loupe pour identifier les menaces et vulnérabilités.

- Séparation des responsabilités : répartir les responsabilités entre plusieurs utilisateurs permet d’éviter qu’un utilisateur dispose d’un contrôle excessif sur un système ou un processus. Ainsi, les opérations sensibles sont exécutées par plusieurs personnes, réduisant par là même le risque de fraude ou d’erreur.

- Examens réguliers des droits d’accès utilisateurs : il est indispensable de passer régulièrement en revue les droits et autorisations d’accès de chaque utilisateur pour s’assurer qu’ils sont toujours d’actualité. Ce processus permet d’identifier et de supprimer les droits d’accès inutiles, réduisant ainsi le risque d’accès non autorisé.

Contrôle d’accès basé sur les rôles, authentification multifacteur, surveillance continue, séparation des responsabilités, examens réguliers des droits d’accès utilisateurs… toutes ces mesures permettent aux entreprises d’agir sur plusieurs tableaux pour renforcer la sécurité du cloud, se protéger contre des menaces en constante évolution, réduire la surface d’attaque et empêcher les accès non autorisés aux données et ressources sensibles.

Avantages de la microsegmentation

La microsegmentation apporte des avantages tangibles dans quatre grands domaines, à savoir :

- Réduction de la surface d’attaque : la microsegmentation offre une visibilité sur l’ensemble de l’environnement réseau, sans pour autant ralentir le développement ou l’innovation. De fait, les développeurs d’applications peuvent définir systématiquement des politiques de sécurité dès le début du cycle de développement, tout en veillant à ce que ni les mises à jour ni les déploiements applicatifs n’ouvrent la voie à de nouveaux vecteurs d’attaque. Un aspect particulièrement important dans le monde en évolution rapide du DevOps.

- Neutralisation plus efficace des compromissions : grâce à la microsegmentation, les équipes de sécurité ont toutes les cartes en main pour surveiller le trafic réseau en fonction de politiques prédéfinies, tout en accélérant la réponse et la résolution des incidents.

- Renforcement de la conformité règlementaire : la microsegmentation permet aux Responsables conformité d’élaborer des politiques qui isolent les systèmes soumis à réglementation du reste de l’infrastructure. De même, le contrôle granulaire des communications avec les systèmes réglementés réduit le risque d’utilisation non conforme.

- Simplification de la gestion des politiques : opter pour un réseau microsegmenté ou un modèle de sécurité Zero Trust permet de simplifier la gestion des politiques. Et pour aller encore plus loin, certaines solutions de microsegmentation détectent automatiquement les applications et suggèrent des politiques adaptées au comportement de ces dernières.

Cas d’usage de la microsegmentation

La microsegmentation couvre un large éventail de cas d’usage qui ne cesse de s’enrichir. Voici quelques exemples concrets :

- Systèmes de développement et de production : dans la plupart des cas, les organisations assurent une stricte séparation entre environnements de développement/test et systèmes de production. Malheureusement, ces précautions n’empêchent pas certaines imprudences, comme les développeurs qui extraient des informations clients des bases de données de production à des fins de test. Pour éviter ce type de comportement, la microsegmentation peut restreindre de façon granulaire les connexions entre les deux environnements.

- Sécurité des actifs immatériels : informations confidentielles sur les clients et les employés, propriété intellectuelle, données financières… les actifs immatériels représentent un capital à protéger impérativement. Il en va de la réputation et de la santé financière de l’entreprise. Dans cette optique, la microsegmentation ajoute un niveau de sécurité supplémentaire pour se prémunir contre les exfiltrations et autres actions malveillantes qui peuvent provoquer des interruptions et perturber les opérations.

- Gestion des clouds hybrides : la microsegmentation assure une protection transparente des applications transverses à plusieurs clouds. En parallèle, elle permet de déployer des politiques de sécurité homogènes à l’échelle d’environnements hybrides regroupant de multiples data centers et fournisseurs de services cloud.

- Réponse à incident : comme nous l’avons vu précédemment, la microsegmentation limite la latéralisation des menaces et l’impact des compromissions. Mais ce n’est pas tout. Les données de journalisation aident les équipes de réponse à incident à mieux cerner les tactiques d’attaque, tandis que la télémétrie permet d’identifier les violations de politiques au niveau d’applications spécifiques.

FAQ sur la microsegmentation

Existe-t-il des différences entre la segmentation et la microsegmentation du réseau ?

Si la segmentation et la microsegmentation du réseau contribuent toutes deux à améliorer la sécurité et les performances du réseau, elles n’en restent pas moins fondamentalement différentes. La segmentation traditionnelle du réseau se concentre sur le trafic nord-sud entrant et sortant du réseau, et est déployée à l’aide de divers équipements (VLAN, pare-feu, routeurs, etc.). Ces derniers peuvent être configurés pour appliquer des politiques de sécurité, de type listes de contrôle d’accès ou règles de pare-feu, au niveau du réseau.

De son côté, la microsegmentation se concentre sur le trafic est-ouest et est généralement mise en œuvre à l’aide de solutions de sécurité logicielles, telles que des pare-feu basés sur les hyperviseurs ou des plateformes de protection des terminaux (EPP). Autre spécificité, elle applique les politiques de sécurité au niveau du workload ou de l’application, plutôt qu’au niveau du réseau.

Qu’est-ce qu’une politique de pare-feu ?

Une politique de pare-feu définit comment les pare-feu d’une entreprise doivent gérer le trafic réseau entrant et sortant pour certaines adresses IP et plages d’adresses. Elle peut prendre en compte différents critères : identité des utilisateurs, activité réseau, applications ou encore adresses IP.

Qu’est-ce qu’un réseau virtuel ?

Un réseau virtuel utilise un logiciel pour connecter des ordinateurs, machines virtuelles (VM), serveurs ou serveurs virtuels via Internet. À l’inverse, un réseau physique classique est déployé sur un site fixe à l’aide d’équipements et de câbles.

Qu’est-ce qu’une dépendance d’application ?

On parle de dépendance d’application lorsque des logiciels, applications, serveurs et d’autres composants dépendent les uns des autres pour exécuter leurs fonctions. Pour garantir la continuité des services, les dépendances d’applications doivent être clairement mappées avant la migration vers le cloud, le transfert des composants vers un nouvel environnement cloud ou la mise en œuvre de la microsegmentation.