-

- Explication de la détection et de la réponse aux données

- Pourquoi le DDR est-il important ?

- Améliorer les solutions de DSPM grâce à la surveillance dynamique

- Un regard plus attentif sur la détection et la réponse aux données (DDR)

- Fonctionnement des solutions DDR

- Quelle est la place de la DDR dans le paysage de la sécurité des données du cloud ?

- L'agenda du RSSI a-t-il besoin d'un outil supplémentaire en matière de cybersécurité ?

- Soutenir l'innovation sans sacrifier la sécurité

- FAQ sur la DSPM et la détection et la réponse aux données

Qu'est-ce que la détection et la réponse des données (DDR) ?

Sommaire

La détection et la réponse aux données (DDR) est une solution technologique conçue pour détecter et répondre aux menaces de sécurité liées aux données en temps réel. Elle se concentre sur la surveillance des données à leur source, ce qui permet aux organisations d'identifier des menaces qui pourraient ne pas être détectées par les solutions de sécurité traditionnelles axées sur l'infrastructure. DDR analyse constamment les journaux d'activité des données, tels que ceux d'AWS CloudTrail et d'Azure Monitor, afin d'identifier les accès anormaux aux données et les comportements suspects révélateurs de menaces potentielles. Dès qu'une menace est détectée, DDR déclenche des alertes pour avertir les équipes de sécurité, ce qui permet de réagir rapidement pour contenir et atténuer la menace.

Explication de la détection et de la réponse aux données

Au cœur d'une solution DDR se trouvent des algorithmes avancés d'analyse de données et de machine learning qui surveillent et analysent constamment de vastes quantités de données générées par les services cloud, les réseaux et les applications d'une organisation.

Ces puissantes capacités d'analyse permettent à la solution DDR de détecter les anomalies, les vulnérabilités et les activités suspectes en temps réel. En tirant parti de l'analyse prédictive et comportementale, les systèmes DDR peuvent souvent identifier les menaces avant qu'elles ne causent des dommages importants. Une fois qu'une menace potentielle est détectée, le processus de DDR passe à la phase de réponse, une série d'actions prédéfinies et automatisées conçues pour contenir et neutraliser la menace.

Les mesures d'intervention peuvent consister à bloquer le trafic réseau suspect, à isoler les appareils infectés, à mettre à jour les politiques de sécurité ou à déclencher des alertes auprès des équipes de sécurité pour qu'elles mènent une enquête et prennent des mesures correctives. L'efficacité d'un système de DDR réside dans sa capacité à s'intégrer aux outils et technologies de sécurité pour une approche globale et coordonnée de la sécurité des données dans le cloud.

Le caractère constant est la clé du DDR

Il est important de noter que le DDR n'est pas une mise en œuvre unique. La détection des menaces et la réponse à ces menaces est un processus continu qui exige une surveillance constante, la collecte de renseignements sur les menaces et la mise à jour des protocoles de réponse. À mesure que le paysage des menaces évolue et que de nouveaux vecteurs d'attaque apparaissent, les organisations doivent régulièrement revoir et affiner leurs stratégies de DDR pour s'assurer qu'elles restent efficaces et adaptables.

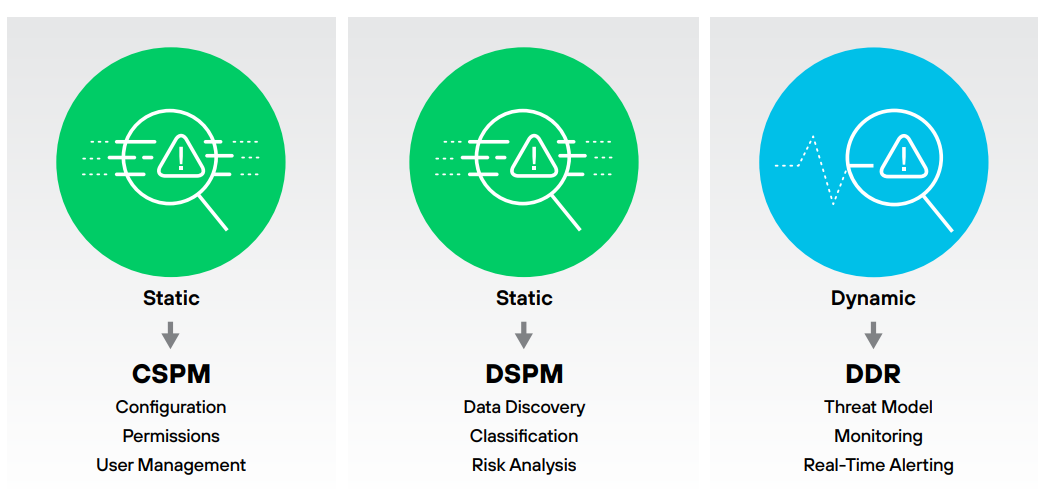

En s'appuyant sur des analyses de données avancées et des mécanismes de réponse automatisés, DDR permet aux organisations de fortifier leur posture de sécurité des données du cloud et d'atténuer l'impact des incidents de sécurité. Via cette couche de défense dynamique, DDR complète les mesures de sécurité statiques fournies par les solutions cloud security posture management (CSPM) et data security posture management (DSPM) , créant ainsi une approche holistique de la protection des données sensibles dans l'ensemble de l'entreprise.

Pourquoi le DDR est-il important ?

La détection et la réponse aux données sont essentielles dans le paysage dynamique de la cybersécurité d'aujourd'hui, où les risques posés par les violations de données ont atteint des niveaux sans précédent. Le rapport 2024 Data Breach Investigations Report (DBIR) brosse un tableau inquiétant, révélant un nombre stupéfiant de 10 626 violations de données confirmées - le nombre le plus élevé enregistré à ce jour.

Comprendre l'étendue du paysage des violations de données

Un pourcentage important (68 %) des violations analysées dans le DBIR impliquait un élément humain, ce qui souligne la nécessité pour les organisations de donner la priorité à des solutions de DDR capables d'identifier rapidement les erreurs humaines et d'y répondre. Pour compliquer la situation, le rapport met en évidence une augmentation spectaculaire de 180 % des violations initiées par l'exploitation de vulnérabilités par rapport aux années précédentes.

Et puis il y a les ransomwares. Personne ne pense que cela lui arrivera, et pourtant les ransomwares et les techniques d'extorsion ont représenté 32 % de toutes les brèches, toujours en citant le DBIR 2024. La mise en œuvre de stratégies efficaces de détection des données et de réponse aidera les organisations à identifier rapidement les menaces et à en atténuer l'impact, en sauvegardant les données sensibles et en préservant la réputation et la santé financière de l'organisation.

Un regard plus attentif sur les risques les plus importants pour les données

Comme indiqué ci-dessus, plusieurs facteurs - dont l'erreur humaine - mettent les données en danger. À cela s'ajoutent les données fantômes et la fragmentation des données, qui introduisent chacune des vulnérabilités uniques susceptibles de compromettre l'intégrité, la confidentialité et la disponibilité des données.

Erreur humaine : Le risque sous-jacent

L'erreur humaine reste la menace la plus répandue pour la sécurité des données. Qu'il s'agisse d'une suppression accidentelle, d'une mauvaise gestion des informations sensibles, d'une utilisation insuffisante des mots de passe ou d'un hameçonnage, les individus créent souvent des vulnérabilités involontaires. Même les systèmes de sécurité les plus sophistiqués peuvent être sapés par une simple erreur, ce qui fait de l'erreur humaine un risque fondamental qui imprègne tous les aspects de la sécurité des données.

Données sur les ombres

L'une des conséquences les plus préoccupantes de l'erreur humaine est la prolifération des données fictives. Ce terme désigne les données qui existent en dehors des systèmes officiellement gérés et sécurisés, souvent stockées dans des services cloud non autorisés, sur des appareils personnels ou dans des sauvegardes oubliées.

Les données fantômes échappent généralement aux protocoles de sécurité habituels, ce qui les rend particulièrement vulnérables aux violations. Les employés peuvent, par inadvertance, créer ou stocker ces données dans des endroits non sécurisés, sans être conscients des risques qu'ils encourent. La nature cachée des données de l'ombre crée un point aveugle dans la stratégie de sécurité de l'organisation.

Fragmentation des données dans l'écosystème multicloud

Dans un environnement multicloud, la fragmentation des données est un facteur de risque inhérent. Les données étant réparties sur plusieurs plateformes cloud, souvent avec des normes de sécurité et des pratiques de gestion variables, il devient de plus en plus difficile de maintenir une protection cohérente. La fragmentation complique bien sûr l'application de politiques de sécurité uniformes et augmente la surface d'attaque - notamment lors du transfert de données entre les clouds. Le manque de visibilité et de contrôle sur des données fragmentées exacerbe encore le risque, rendant difficile le suivi des mouvements de données, la détection des anomalies ou la conformité réglementaire.

L'intersection des risques

Les facteurs de risque liés aux données se recoupent lorsque l'erreur humaine conduit à la création de données fantômes, qui à leur tour augmentent le risque lorsque les données sont fragmentées dans un environnement multicloud. Considérez maintenant que les données sont fréquemment en mouvement, se déplaçant d'un endroit à l'autre. Ces risques créent une sorte de triangle des Bermudes s'ils ne sont pas protégés efficacement.

Améliorer les solutions de DSPM grâce à la surveillance dynamique

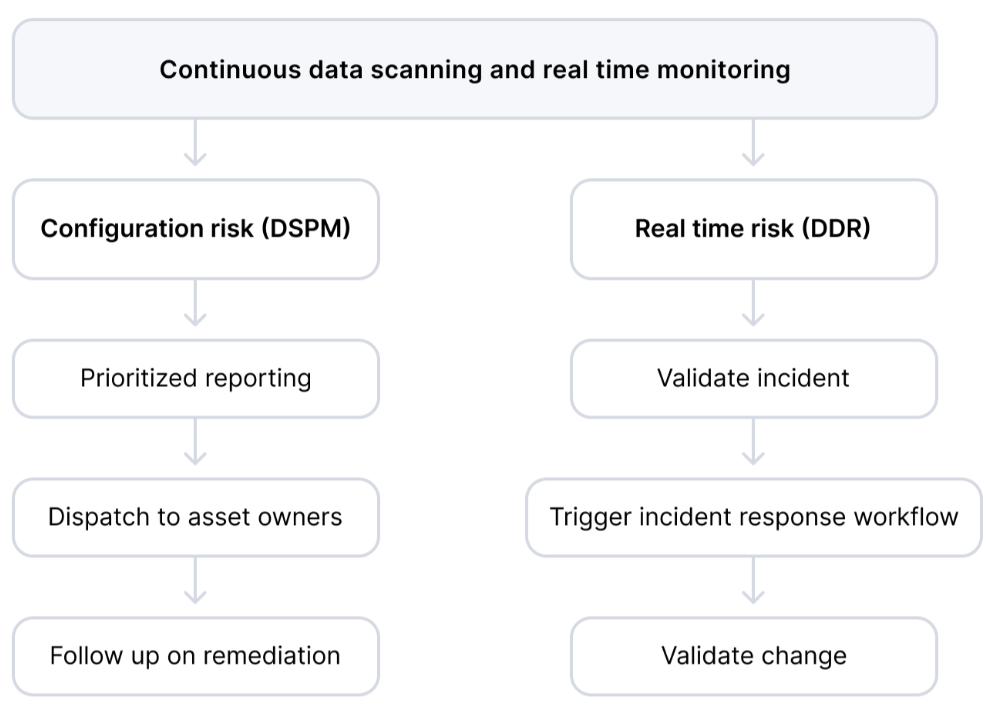

Les capacités de DSPM dont nous avons parlé jusqu'à présent se réfèrent principalement au risque statique - trouver des données sensibles, les classer et examiner les contrôles d'accès et les configurations qui leur sont appliqués.

Cependant, pour maintenir une posture efficace en matière de sécurité des données, vous devez constamment surveiller et analyser les schémas d'accès aux données et le comportement des utilisateurs. C'est précisément ce que fait la détection et la réponse aux données (DDR).

DDR offre des capacités de surveillance et d'alerte en temps réel pour aider les équipes de sécurité à détecter rapidement les menaces potentielles et les activités suspectes et à y répondre - tout en donnant la priorité aux problèmes qui mettent en péril les données sensibles. En s'appuyant sur des algorithmes d'apprentissage automatique et des analyses de journaux avancées, DDR peut identifier les anomalies dans le comportement des utilisateurs et les schémas d'accès qui indiquent potentiellement un compte compromis ou une menace initiée.

Un regard plus attentif sur la détection et la réponse aux données (DDR)

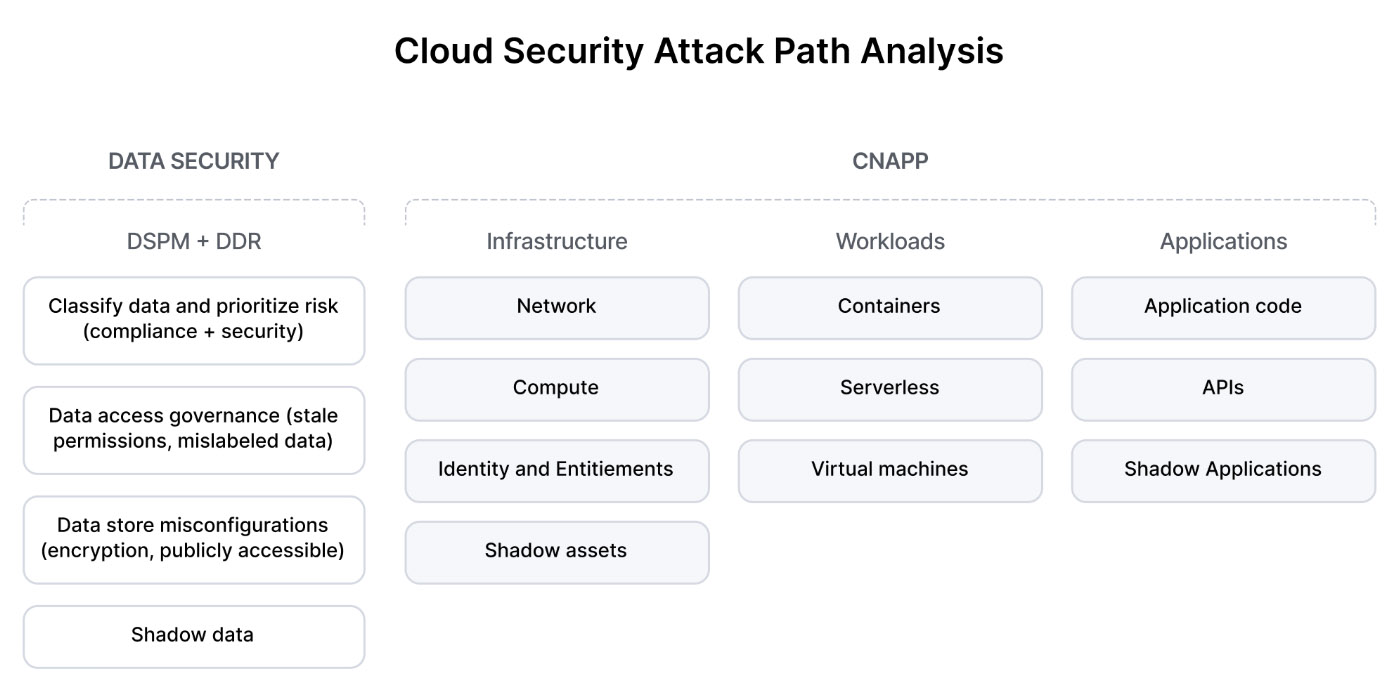

La DDR décrit un ensemble de solutions technologiques utilisées pour sécuriser les données du cloud contre l'exfiltration. Il assure une surveillance dynamique au-dessus des couches de défense statiques fournies par les outils CSPM et DSPM.

Les organisations d'aujourd'hui stockent des données dans divers environnements cloud - PaaS (par exemple, Amazon RDS), IaaS (machines virtuelles exécutant des datastores) et DBaaS (par exemple, Snowflake) - et il n'est pas possible de surveiller chaque action sur les données. Les solutions DDR utilisent l'analyse des journaux en temps réel pour surveiller les environnements cloud qui stockent des données et détecter les risques liés aux données dès qu'ils se produisent.

Fonctionnement des solutions DDR

Les solutions de détection et de réponse aux données intègrent des capacités de DSPM pour découvrir et classer les actifs de données , identifier les risques tels que les données sensibles non cryptées ou les violations de la souveraineté des données, et hiérarchiser les mesures correctives prises par les propriétaires de données ou le service informatique. Une fois les actifs de données sensibles cartographiés, les solutions DDR surveillent l'activité par le biais d'une journalisation Cloud Native disponible dans les clouds publics, générant des journaux d'événements pour chaque requête ou demande de lecture.

L'outil DDR analyse les journaux en temps quasi réel, en appliquant un modèle de menace pour détecter les activités suspectes, telles que les données circulant vers des comptes externes. Lorsqu'elle identifie de nouveaux risques, la DDR émet des alertes et propose des actions immédiates. Ces alertes sont souvent intégrées dans des solutions SOC ou SOAR (security orchestration, automation, and response) pour une résolution plus rapide et un alignement transparent sur les opérations existantes.

Cas d'utilisation DDR

Pour vous faire une idée des types d'incidents auxquels une solution DDR permet de remédier, prenez quelques exemples observés chez nos utilisateurs.

Questions relatives à la souveraineté des données

La législation de ces dernières années crée des obligations de stockage des données dans des zones géographiques spécifiques (telles que l'UE ou la Californie). La DDR permet de détecter les flux de données vers un emplacement physique non autorisé, ce qui permet d'éviter les problèmes de conformité en aval.

Biens transférés dans un lieu de stockage non crypté ou non sécurisé

Lorsque les données circulent entre les bases de données et le stockage cloud, elles peuvent se frayer un chemin vers un datastore non sécurisé (souvent le résultat d'une solution de contournement temporaire mais oubliée). Le DDR alerte les équipes de sécurité sur ce type de mouvement.

Instantanés et sauvegardes fantômes

Les équipes sont soumises à une pression croissante pour en faire plus avec les données, ce qui conduit à la prévalence de l'analyse fantôme en dehors des flux de travail approuvés. La DDR permet de trouver des copies de données stockées ou partagées d'une manière susceptible d'entraîner des violations.

Quelle est la place de la DDR dans le paysage de la sécurité des données du cloud ?

DDR par rapport à la GPSC et à la GPSC

Gestion de la sécurité du cloud

CSPM consiste à protéger la posture de l'infrastructure cloud (comme des permissions trop généreuses ou une mauvaise configuration). Il n'aborde pas directement les données - leur contexte et la manière dont elles circulent entre les différents services de cloud.

Gestion de la sécurité des données

DSPM protège les données de l'intérieur. En scannant et en analysant les données stockées, les outils de DSPM identifient les informations sensibles telles que les IPI ou les codes d'accès, classent les données et évaluent le risque qui leur est associé. Ce processus offre aux équipes de sécurité une vision plus claire des risques et des flux de données, ce qui leur permet de hiérarchiser les actifs cloud pour lesquels une violation pourrait causer le plus de dommages.

Alors que le DSPM offre une protection plus granulaire des données du cloud, le CSPM et le DSPM sont tous deux statiques et axés sur la posture. Ils permettent aux organisations de comprendre où se situent les risques, mais n'offrent que peu de possibilités en termes de réponse aux incidents en temps réel.

En revanche, le DDR est dynamique. Il se concentre sur les événements de données qui se produisent en temps réel, envoie des alertes et donne aux équipes de sécurité une chance d'intervenir et de prévenir des dommages importants. DDR surveille le niveau d'événement spécifique, alors que d'autres solutions examinent les configurations et les données au repos.

Une situation potentielle

Prenons le cas d'un employé qui dispose d'un accès autorisé, basé sur des rôles, à une base de données contenant des informations sur les clients. Le salarié prévoit de quitter l'entreprise et, avant d'en informer ses supérieurs, il copie la base de données sur son ordinateur portable personnel pour l'emmener dans la prochaine entreprise.

Dans cet exemple, les autorisations permettent à l'employé d'accéder à la base de données - et pourtant, un événement majeur d' exfiltration de données est en train de se produire. Une solution de DDR dotée d'un modèle de menace bien calibré détecte le lot inhabituel de données (et d'autres irrégularités) contenu dans cette exportation. L'outil DDR envoie une alerte aux équipes de sécurité et fournit des informations complètes sur la criminalistique, permettant d'identifier avec précision l'actif et l'acteur impliqués dans l'exfiltration. Gagnant un temps critique, l'équipe de sécurité intervient avant que la menace initiée n'atteigne ses objectifs.

L'agenda du RSSI a-t-il besoin d'un outil supplémentaire en matière de cybersécurité ?

Le DDR offre des fonctionnalités critiques absentes de la pile de sécurité existante du cloud. Lorsque les agents ne sont pas disponibles, vous devez surveiller toutes les activités qui concernent vos données. DDR protège vos données contre l'exfiltration ou l'utilisation abusive, ainsi que contre les violations de la conformité. En s'intégrant aux solutions SIEM et SOAR, permettant aux équipes de consommer les alertes en un seul endroit, DDR contribue à réduire les frais généraux opérationnels.

La nécessité d'une DLP sans agent

Surveiller les actifs de données en temps réel peut sembler évident, mais les organisations, pour la plupart, ne disposent pas d'un moyen adéquat pour protéger les données sensibles. Dans le monde traditionnel, sur place, le travail s'effectuait principalement sur des ordinateurs personnels connectés à un serveur via un intranet. Les équipes de sécurité surveillaient le trafic et l'activité en installant des agents (composants logiciels tels que des outils antivirus) sur chaque appareil et terminal ayant accès aux données de l'organisation.

Mais vous ne pouvez pas installer un agent sur une base de données hébergée par Amazon ou Google ou placer un Proxy devant des milliers de datastores. Le passage à l'infrastructure cloud exige de nouvelles approches en matière de prévention des pertes de données (DLP).

L'industrie a gravité vers des solutions statiques axées sur l'amélioration de la posture de sécurité des datastores dans le cloud (CSPM, DSPM) en détectant les configurations erronées et les actifs de données exposés. Mais le problème du flux de données n'a pas été résolu avant la DDR.

Quand les couches de défense statiques ne suffisent pas : Leçons tirées d'une brèche

La 2018 Imperva breach a commencé par l'accès d'un attaquant à un instantané d'une base de données Amazon RDS contenant des données sensibles. L'attaquant a utilisé une clé API AWS volée à partir d'une instance de calcul accessible au public et mal configurée.

La GPSC et la GPSCD auraient-elles permis d'éviter la violation ?

Une solution CSPM pourrait identifier la configuration erronée, et la DSPM pourrait détecter les données sensibles stockées sur l'instance mal configurée. Cependant, aucun de ces outils n'aurait été en mesure d'identifier le comportement inhabituel de l'attaquant une fois qu'il aurait obtenu un accès apparemment légitime.

En 2018, la brèche d'Imperva n'a été découverte que dix mois plus tard, par un tiers. L'attaquant avait exporté l'instantané de la base de données vers un dispositif inconnu - et pendant ce temps, l'entreprise ignorante ne pouvait pas avertir ses utilisateurs que leurs données sensibles avaient été divulguées.

Une solution DDR aurait permis de combler cette lacune en surveillant le compte AWS au niveau du journal des événements. Identifiant potentiellement l'attaque en temps réel, il aurait alerté les équipes de sécurité internes, leur permettant de réagir immédiatement.

Soutenir l'innovation sans sacrifier la sécurité

Le cloud est là pour rester, tout comme microservices et conteneurs. En tant que professionnels de la cybersécurité, nous ne pouvons pas empêcher l'organisation d'adopter des technologies qui accélèrent l'innovation et donnent plus de flexibilité aux développeurs. Mais nous devons faire tout ce qui est en notre pouvoir pour prévenir les violations de données.

Le DSPM avec DDR offre des capacités essentielles qui manquaient jusqu'à présent dans le paysage de la sécurité du cloud - data discovery, classification, gestion statique des risques et surveillance continue et dynamique d'environnements complexes et multicloud. En offrant aux organisations la visibilité et le contrôle nécessaires pour gérer efficacement leur sécurité des données, les organisations peuvent détecter les incidents plus tôt, ce qui permet d'éviter ou de minimiser les pertes de données désastreuses.

FAQ sur la DSPM et la détection et la réponse aux données

La sécurisation des architectures multicloud implique la gestion de la sécurité entre plusieurs fournisseurs de services cloud, chacun ayant des configurations, des politiques et des exigences de conformité qui lui sont propres.

Des politiques et des contrôles de sécurité cohérents doivent être mis en œuvre dans tous les environnements afin d'éviter les configurations erronées. Le cryptage des données, les contrôles d'accès et la gestion des identités deviennent plus complexes en raison de la disparité des systèmes. La surveillance et la réponse aux incidents nécessitent une intégration entre différentes plateformes, ce qui complique la visibilité et la coordination. Garantir la conformité aux exigences réglementaires dans plusieurs juridictions ajoute encore à la complexité.

Pour relever ces défis, il faut une stratégie de sécurité exhaustive et unifiée et des outils d'automatisation robustes.

Le développement basé sur les microservices présente des défis uniques en matière de sécurité en raison de son architecture décentralisée et modulaire. Chaque microservice fonctionne de manière indépendante, ce qui nécessite des canaux de communication sécurisés et des politiques de sécurité cohérentes. Les développeurs doivent mettre en œuvre des mécanismes robustes d'authentification, d'autorisation et de chiffrement pour protéger les données en transit et au repos. L'augmentation du nombre de terminaux amplifie la surface d'attaque, ce qui nécessite une surveillance constante et une détection des anomalies. Les outils de conteneurisation et d'orchestration comme Kubernetes doivent être configurés de manière sécurisée. Malgré ces difficultés, les microservices permettent une mise à l'échelle rapide et l'isolation des composants compromis, ce qui améliore la résilience globale.

La démocratisation des données vise à rendre les données accessibles à un plus grand nombre d'utilisateurs au sein d'une organisation, en leur donnant les moyens de prendre des décisions éclairées. S'il favorise la collaboration et l'innovation, il pose également des problèmes de sécurité. L'accès accru aux données amplifie le risque d'utilisation non autorisée, de fuites de données et de violations de la conformité. La mise en œuvre de contrôles d'accès robustes, de la classification des données et du chiffrement est essentielle pour atténuer ces risques. Les équipes de sécurité doivent trouver un équilibre entre l'accessibilité et des mesures de sécurité strictes, en veillant à ce que seuls les utilisateurs autorisés puissent accéder aux données sensibles, tout en maintenant la conformité et en se protégeant contre les menaces potentielles.

Un inventaire des données est une liste exhaustive de tous les actifs de données d'une organisation et de leur emplacement. Il aide les organisations à comprendre et à suivre :

- Types de données qu'ils collectent, stockent et traitent ;

- les sources, les finalités et les destinataires de ces données.

Les inventaires de données peuvent être gérés manuellement ou automatiquement. Les raisons de maintenir un inventaire des données varient - et pourraient inclure la gouvernance des données, la gestion des données, la protection des données, la sécurité des données et la conformité des données.

Par exemple, disposer d'un inventaire des données peut aider les organisations à identifier et à classer les données sensibles, à évaluer les risques associés aux différents types de données et à mettre en œuvre des contrôles appropriés pour protéger ces données. Il peut également aider les organisations à comprendre de quelles données elles disposent pour soutenir les objectifs de l'entreprise ou pour générer des types spécifiques de rapports d'analyse.

L'analyse statique des risques consiste à évaluer la sécurité d'un système sans exécuter le code. Les analystes utilisent des outils pour analyser le code source, les fichiers de configuration et les conceptions d'architecture à la recherche de vulnérabilités et de configurations erronées. Des techniques telles que l'analyse statique du code, la modélisation des menaces et les examens architecturaux permettent d'identifier les risques potentiels pour la sécurité à un stade précoce du cycle de développement. Le processus comprend l'examen du code pour détecter les vulnérabilités connues, les pratiques de codage non sécurisées et la conformité aux normes de sécurité. En identifiant les problèmes avant le déploiement, l'analyse statique des risques permet d'atténuer les risques et de garantir une architecture de système plus sûre.

La surveillance dynamique observe constamment les comportements du système et les flux de données en temps réel afin de détecter les incidents de sécurité. Il utilise des techniques avancées comme la détection des anomalies, l'analyse des comportements et l'apprentissage automatique pour identifier les écarts par rapport aux schémas normaux. Les outils surveillent le trafic réseau, les activités des utilisateurs et les interactions avec les applications, et émettent des alertes immédiates dès qu'ils détectent des actions suspectes. La surveillance dynamique s'intègre aux systèmes de réponse aux incidents pour automatiser l'atténuation des menaces. Cette approche proactive garantit une détection et une réponse rapides aux menaces de sécurité, en maintenant l'intégrité et la disponibilité des données dans des environnements complexes.

Les algorithmes d'apprentissage automatique renforcent la sécurité des données en analysant de vastes quantités de données pour identifier des modèles et des anomalies révélateurs de menaces potentielles. Ils apprennent constamment à partir de nouvelles données, améliorant ainsi leur capacité à détecter les vulnérabilités du jour zéro et les attaques sophistiquées. Les algorithmes peuvent automatiser la détection des menaces, ce qui permet de réduire les temps de réponse et de minimiser les erreurs humaines. En corrélant des données provenant de diverses sources, l'apprentissage automatique améliore l'analyse prédictive, ce qui permet d'atténuer les menaces de manière proactive. Ces algorithmes contribuent également à l'analyse du comportement des utilisateurs, à la détection des menaces initiées et des comptes compromis grâce à des écarts par rapport aux lignes de base comportementales établies.

Les données en mouvement sont des données qui sont activement transmises ou transférées sur un réseau ou par un autre canal de communication. Il peut s'agir de données envoyées entre des appareils, par exemple d'un ordinateur à un serveur ou d'un smartphone à un routeur sans fil. Il peut également faire référence à des données transmises sur l'internet ou d'autres réseaux, par exemple entre un stockage local sur place et une base de données dans le cloud. Les données en mouvement se distinguent des données au repos, qui sont des données stockées dans un état persistant.

Les données en cours d'utilisation sont celles qui sont activement stockées dans la mémoire de l'ordinateur, comme la mémoire vive, les caches de l'unité centrale ou les registres de l'unité centrale. Les données ne sont pas stockées passivement dans un endroit stable, mais circulent dans différents systèmes, chacun d'entre eux pouvant être vulnérable à des attaques. Les données en cours d'utilisation peuvent être la cible de tentatives d'exfiltration car elles peuvent contenir des informations sensibles telles que des données PCI ou PII.

Pour protéger les données en cours d'utilisation, les organisations peuvent utiliser des techniques de chiffrement telles que le chiffrement de bout en bout (E2EE) et des approches matérielles telles que l'informatique confidentielle. Au niveau des politiques, les organisations doivent mettre en œuvre des contrôles d'authentification et d'autorisation des utilisateurs, revoir les autorisations des utilisateurs et surveiller les événements liés aux fichiers.

La surveillance des flux de données consiste à suivre le mouvement des données au sein d'un réseau afin d'en garantir l'intégrité, la confidentialité et la disponibilité. Il utilise des outils avancés pour analyser les paquets de données en temps réel et identifier les accès non autorisés et les tentatives d'exfiltration de données. Les systèmes de surveillance peuvent détecter des anomalies dans les taux de transfert de données, des temps d'accès inhabituels et des chemins de données atypiques. En s'intégrant aux systèmes de gestion des informations et des événements de sécurité (SIEM), la surveillance des flux de données offre une visibilité complète sur les activités du réseau. Cette visibilité est cruciale pour détecter les incidents de sécurité et y répondre rapidement, garantissant ainsi la conformité aux exigences réglementaires.

Le cheminement des données permet de suivre le flux de données à travers les systèmes d'une organisation, depuis leur origine jusqu'à leur destination finale. Les outils capturent des métadonnées sur les transformations, les mouvements et l'utilisation des données, offrant ainsi une vue de bout en bout des processus de données. Les analystes utilisent ces informations pour garantir l'intégrité des données, détecter les erreurs et maintenir la conformité avec les exigences réglementaires. La traçabilité des données facilite l'analyse d'impact, en identifiant les dépendances et les risques potentiels associés aux changements de données. Il facilite également l'audit et l'établissement de rapports, permettant aux organisations de démontrer aux parties prenantes et aux organismes de réglementation leurs pratiques en matière de gouvernance et de sécurité des données.

Les instantanés sont des copies ponctuelles de données stockées dans un système, qui permettent de capturer l'état des données à un moment précis. Ils sont utilisés dans la sécurité des données pour permettre une récupération rapide en cas de corruption des données, de suppressions accidentelles ou d'attaques de ransomware. Les instantanés peuvent être pris manuellement ou automatiquement à intervalles réguliers et stockés séparément des données primaires. Elles permettent une restauration efficace des données sans avoir recours à des sauvegardes complètes, ce qui minimise les temps d'arrêt et les pertes de données. Dans les environnements cloud, les instantanés offrent des solutions évolutives et économiques pour maintenir la disponibilité et l'intégrité des données.

Les systèmes de sécurité analysent les schémas d'accès en collectant et en évaluant les journaux provenant de différentes sources, telles que les systèmes d'authentification, les serveurs de fichiers et les applications. Les algorithmes d'apprentissage automatique et les méthodes heuristiques identifient les écarts par rapport au comportement normal. Les analystes examinent des paramètres tels que les heures de connexion, les adresses IP et les ressources consultées. Des schémas d'accès inhabituels, tels que des échecs répétés de tentatives de connexion ou des accès à partir d'endroits inconnus, déclenchent des alertes qui nécessitent des investigations plus approfondies. La surveillance et l'analyse constantes permettent d'identifier les comptes compromis, les menaces d'initiés et les violations de politiques. Cette approche proactive garantit un contrôle d'accès solide et atténue les risques potentiels en matière de sécurité.

Dans le domaine de la sécurité des données, les anomalies d'utilisation désignent les écarts par rapport aux modèles établis d'accès et d'utilisation des données qui peuvent indiquer une activité malveillante. Il peut s'agir, par exemple, de pics inattendus dans les volumes de transfert de données, d'accès à des fichiers sensibles à des heures inhabituelles ou de tentatives de connexion à partir d'emplacements géographiques atypiques. Les algorithmes d'apprentissage automatique et les modèles statistiques analysent le comportement des utilisateurs pour établir des lignes de base, ce qui facilite la détection des anomalies. L'identification de ces anomalies est cruciale pour la détection précoce des menaces, car elles précèdent souvent les violations de données ou les attaques d'initiés. La surveillance constante et les alertes en temps réel permettent de réagir rapidement pour atténuer les incidents de sécurité potentiels.

La classification des données dans les systèmes de sécurité consiste à classer les données en fonction de leur sensibilité et de leur criticité. Des outils automatisés analysent les référentiels de données, en utilisant des politiques prédéfinies et des algorithmes d'apprentissage automatique pour étiqueter les données avec des classifications appropriées, telles que confidentiel, interne ou public. Les politiques de classification prennent en compte des facteurs tels que les exigences réglementaires, la propriété des données et l'impact sur l'entreprise. Des balises de métadonnées sont appliquées aux objets de données, ce qui permet un contrôle d'accès et un cryptage très précis. Cette approche structurée garantit que les données sensibles bénéficient d'une protection appropriée, facilite les efforts de conformité et améliore la posture de sécurité globale en limitant l'accès aux seuls utilisateurs autorisés.

L'alerte en temps réel est un mécanisme de sécurité qui fournit des notifications immédiates en cas de détection d'activités suspectes ou de violations des règles. Il s'intègre aux systèmes de surveillance et utilise des règles prédéfinies et des algorithmes de détection des menaces pour identifier les menaces potentielles. Les alertes peuvent être envoyées par différents canaux, notamment par courrier électronique, SMS ou tableaux de bord intégrés, ce qui permet aux équipes de sécurité de réagir rapidement. L'alerte en temps réel réduit la fenêtre d'opportunité pour les attaquants en permettant une réponse rapide à l'incident. Cette approche proactive renforce la capacité d'une organisation à prévenir les violations de données, à limiter les dommages et à maintenir la conformité avec les politiques et les réglementations en matière de sécurité.

La souveraineté des données fait référence aux exigences légales et réglementaires régissant les données stockées au sein d'une juridiction particulière. Elle exige que les données soient conformes aux lois sur la protection de la vie privée et la sécurité du pays où elles se trouvent physiquement. Les organisations doivent naviguer dans des réglementations internationales complexes pour s'assurer que les données sont traitées de manière appropriée, en particulier lorsqu'elles utilisent des services de cloud. La souveraineté des données a un impact sur les stratégies de stockage des données, nécessitant des centres de données localisés et des contrôles d'accès spécifiques. La conformité aux lois sur la souveraineté des données est cruciale pour éviter les sanctions juridiques et maintenir la confiance des clients, en particulier dans les régions dotées de réglementations strictes en matière de protection des données, telles que le GDPR de l'UE.

Les sauvegardes virtuelles sont des sauvegardes incrémentielles qui ne capturent que les modifications apportées aux données depuis la dernière sauvegarde. Ils utilisent des techniques telles que la différenciation au niveau des blocs ou des fichiers pour minimiser les exigences en matière de stockage et réduire les fenêtres de sauvegarde. Les sauvegardes fantômes sont essentielles pour garantir l'intégrité et la disponibilité des données, en particulier dans les environnements où les taux de modification des données sont élevés. Ils permettent une récupération rapide en fournissant plusieurs points de restauration, ce qui facilite le retour à un état antérieur en cas de corruption ou de perte de données. Les organisations utilisent des sauvegardes fictives pour améliorer les plans de reprise après sinistre et maintenir la continuité des activités.

Dans le domaine de la sécurité des données, les mécanismes de réponse automatisée exécutent des actions prédéfinies en réponse à la détection des menaces, minimisant ainsi la fenêtre d'exposition. Ils s'intègrent aux systèmes de surveillance et d'alerte pour déclencher des réactions telles que l'isolement des systèmes compromis, la révocation de l'accès des utilisateurs ou le cryptage des données. L'automatisation réduit la nécessité d'une intervention manuelle, accélère la réponse aux incidents et diminue la probabilité d'une erreur humaine. Ces mécanismes renforcent le dispositif de sécurité global en garantissant des actions cohérentes et rapides contre les menaces potentielles, ce qui permet aux organisations de maintenir une continuité opérationnelle et de se conformer aux exigences réglementaires.

La mise en quarantaine des données consiste à isoler les données suspectes ou compromises afin d'empêcher la propagation des menaces au sein d'un réseau. Les systèmes de sécurité détectent automatiquement les anomalies ou les violations de règles et déplacent les données concernées vers une zone de quarantaine. Cette zone restreint l'accès, ce qui permet aux équipes de sécurité d'analyser la menace et d'y remédier sans affecter les autres données. La mise en quarantaine permet de contenir les logiciels malveillants, les ransomwares et les menaces initiées, réduisant ainsi le risque de compromission généralisée des données. La mise en œuvre d'une quarantaine de données dans le cadre d'une stratégie de réponse aux incidents permet de neutraliser rapidement les menaces et de préserver l'intégrité et la sécurité de l'ensemble de l'environnement de données.

L'élaboration d'un modèle de menace consiste à identifier, évaluer et traiter systématiquement les menaces potentielles pour la sécurité d'un système. Les experts en sécurité commencent par définir l'architecture du système, les flux de données et les points d'entrée. Ils identifient ensuite les menaces potentielles, les classent en fonction du risque et évaluent leur impact et leur probabilité. Des techniques telles que STRIDE (Spoofing, Tampering, Repudiation, Information Disclosure, Denial of Service, Elevation of Privilege) permettent de classer les menaces. L'équipe hiérarchise les menaces et recommande des stratégies d'atténuation. L'examen et la mise à jour constants du modèle de menace sont essentiels pour faire face à l'évolution des défis en matière de sécurité.

L'analyse du comportement de l'utilisateur consiste à surveiller et à évaluer les activités de l'utilisateur afin de détecter les anomalies révélatrices de menaces potentielles pour la sécurité. Des algorithmes avancés d'analyse et d'apprentissage automatique établissent des lignes de base pour le comportement normal des utilisateurs en analysant les données historiques. Des outils de surveillance en temps réel comparent ensuite les activités en cours à ces lignes de base afin d'identifier les écarts, tels que des temps de connexion inhabituels, l'accès à des ressources atypiques ou des volumes de transfert de données anormaux. Les alertes se déclenchent dès la détection d'un comportement suspect, ce qui permet une investigation et une réponse rapides. Cette approche proactive permet d'identifier les comptes compromis, les menaces initiées et les violations de politiques, renforçant ainsi la sécurité globale.