Nouveaux vecteurs d’attaque IA

Le déploiement de nouveaux pipelines et de nouvelles infrastructures sans visibilité unifiée expose les entreprises à des attaques jamais vues auparavant.

Nouveaux vecteurs d’attaque IA

Le déploiement de nouveaux pipelines et de nouvelles infrastructures sans visibilité unifiée expose les entreprises à des attaques jamais vues auparavant.

Prolifération des modèles

Sans un inventaire exhaustif des assets d’IA, les organisations laissent le champ libre au Shadow AI, avec tous les risques que cela comporte en termes de conformité et d’exfiltration de données via les applications d’IA.

Manque de gouvernance

Les nouvelles lois sur la sécurité de l’IA imposent des contrôles stricts sur son utilisation et sur les données clients qui alimentent ces outils.

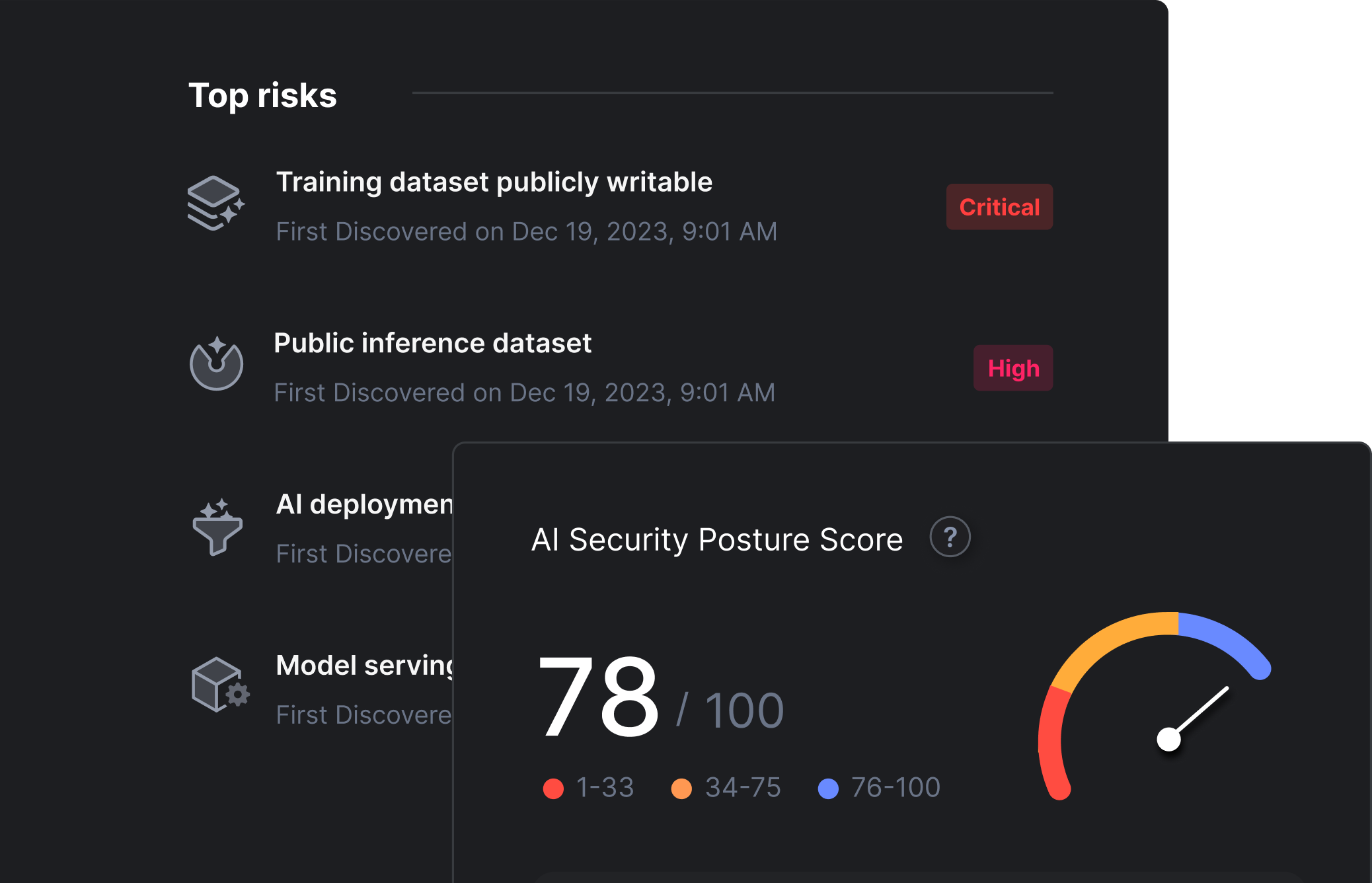

Libérez toute la puissance transformative de l’IA et des grands modèles de langage (LLM) sans mettre votre entreprise en danger. Prisma® Cloud AI Security Posture Management (AI-SPM) vous offre la visibilité et le contrôle nécessaires sur les trois piliers de la sécurité IA : les données pour l’entraînement ou l’inférence, l’intégrité des modèles IA et l’accès aux modèles déployés.

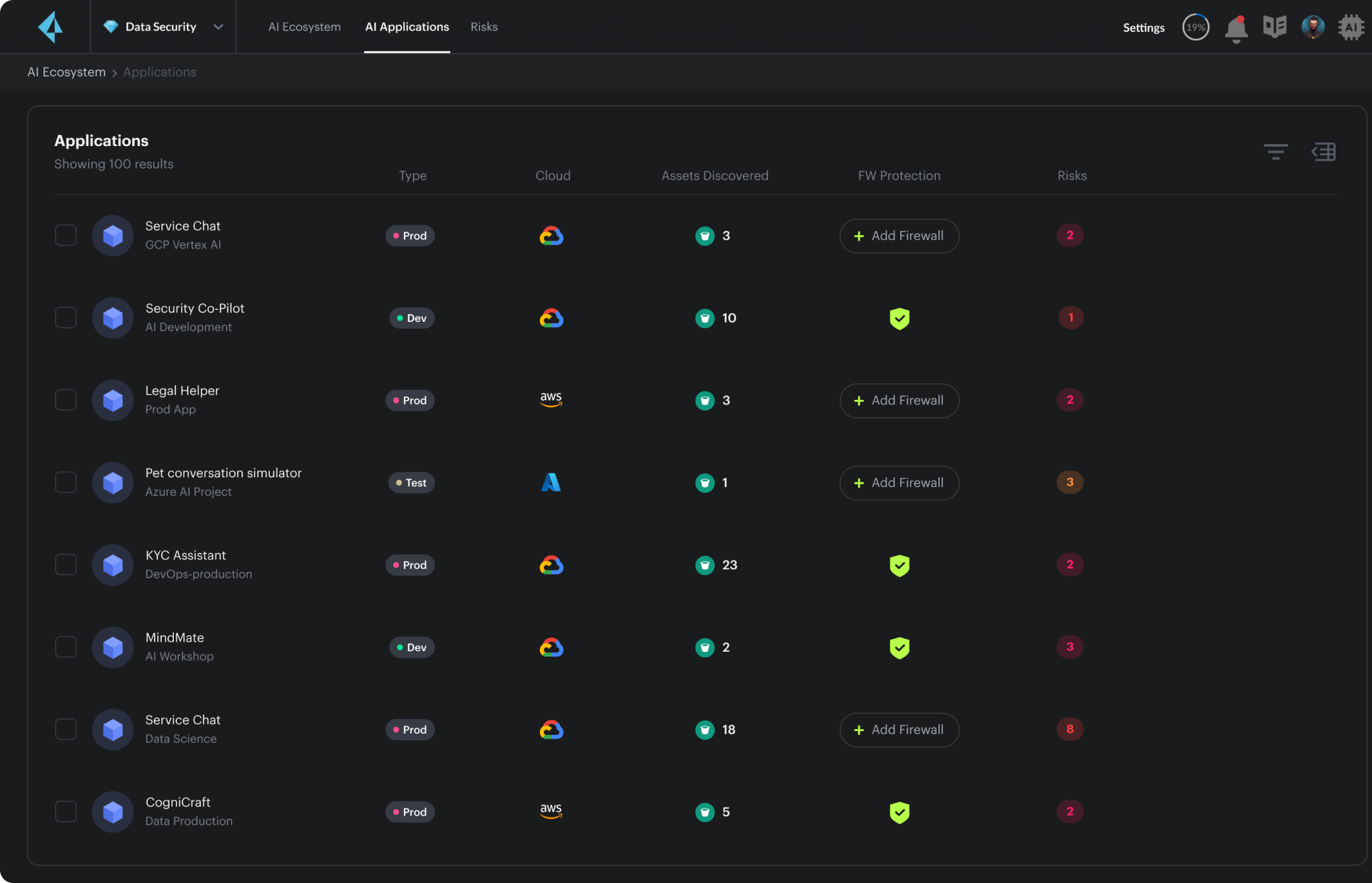

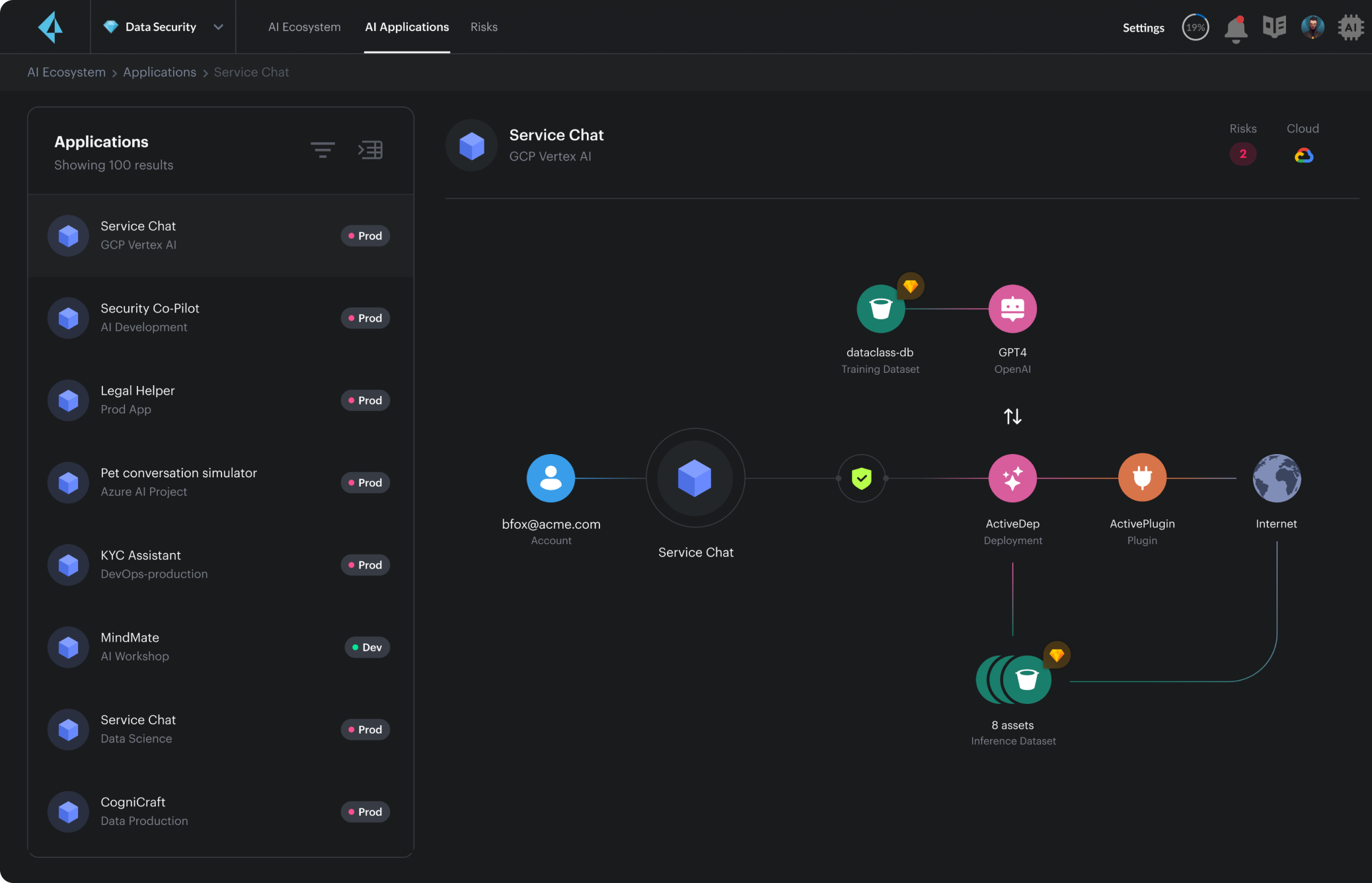

Identifiez les applications d’IA, les modèles et les ressources associées. Assurez la traçabilité et le lignage de tous les composants d’IA utilisés dans les applications.

Découverte des applications d’IA

Identifiez les applications d’IA, les modèles et les ressources associées.

Lignage des composants d’IA

Assurez la traçabilité de tous les composants d’IA et des sources de données utilisés dans les applications.

Inventaire des modèles

Cataloguez les modèles d’IA déployés et identifiez leurs mises à jour.

Identifiez les vulnérabilités dans la supply chain IA, les modèles mal configurés et les ressources cloud associées qui entraînent un risque de vol de données, de manipulation ou de détournement.

Prévention des compromissions de modèles et du vol de données

Identifiez le risque de création de modèles similaires par des acteurs malveillants.

Détection des erreurs de configuration

Éliminez les autorisations trop permissives sur les instances de calcul et les modèles d’IA.

Blocage des conceptions plug-in non sécurisées

Identifiez les agents/workloads vulnérables ou dotés de droits trop étendus.

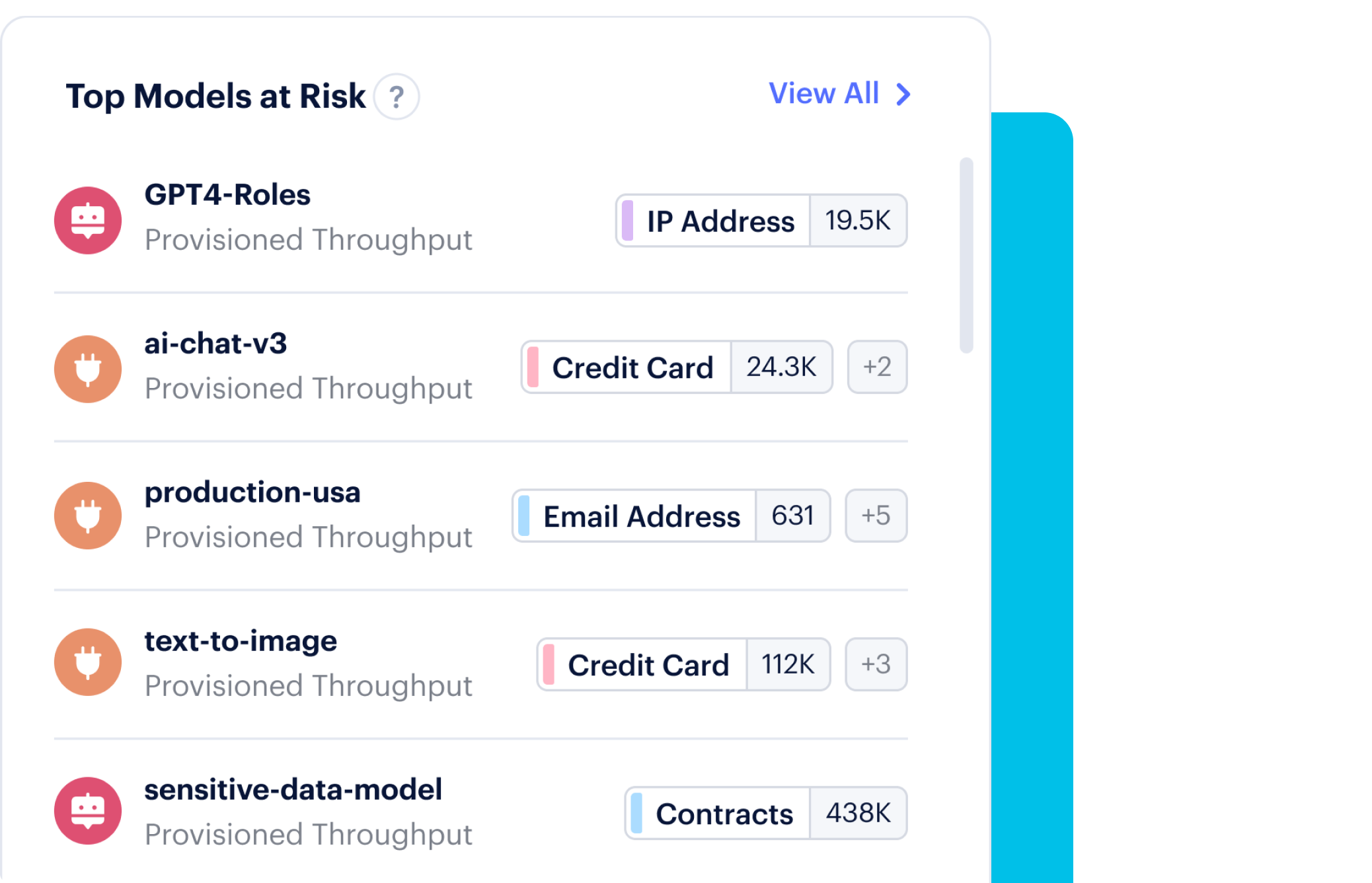

La manipulation des données de modèles d’IA introduit des biais et des vulnérabilités exposant l’entreprise à de nombreux risques : fuite et compromission de données, problèmes de conformité, etc.

Classification de la stack IA

Identifiez les données sensibles dans les données d’entraînement ou d’inférence, les bibliothèques, les API et les pipelines data qui alimentent les modèles d’IA.

Surveillance des données sensibles

Prévenez l’exposition des données, l’empoisonnement des modèles, les compromissions et les violations des principes de confidentialité.

Priorisation des vulnérabilités

Corrigez les vulnérabilités dans les infrastructures hébergeant des outils d’IA qui accèdent à des données sensibles.